ニュース

GMOインターネット、「GMO GPUクラウド」で「NVIDIA HGX B300」のクラウドサービスを提供

2025年12月17日 11:00

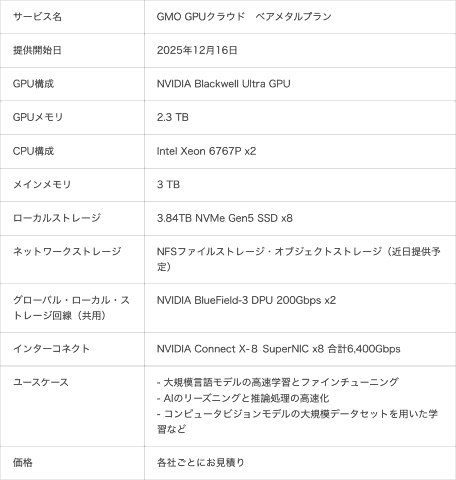

GMOインターネット株式会社は16日、GPUクラウドサービス「GMO GPUクラウド」において、NVIDIA Blackwell Ultra GPUを搭載した「NVIDIA HGX B300 AIインフラストラクチャ(以下、HGX B300)」を導入したクラウドサービスの提供を開始した。

サービスは、サーバー1台を専有するベアメタル構成により、AI推論モデルに最適化されたHGX B300の性能を引き出し、大規模言語モデルの高速推論やエージェント型AI開発など、最先端AIワークロードに最適な高性能環境を国内から提供する。GMOインターネットでは、AI・ロボティクス時代の研究開発のみならず、その利活用を支える新たな計算基盤として展開していくとしている。

GMOインターネットは、2024年4月15日に経済安全保障推進法に基づく特定重要物資「クラウドプログラム」の供給確保計画に関する経済産業省の認定を受け、同年11月22日からNVIDIA Hopper GPU環境を提供している。さらに市場環境や技術的要請を踏まえ、GMOインターネットではBlackwellアーキテクチャの最新世代「HGX B300」への切り替えを決定した。これにより、GMO GPUクラウドは、今後のAI開発・運用に求められる高い計算性能・拡張性・低レイテンシー通信に対応し、さらに進化したインフラ基盤として展開していくとしている。

NVIDIA Blackwell Ultra GPUは、メモリ容量が288GB(H200比204%)となり、新たにFP4演算精度に対応。FP8 Tensor Core性能も最大2.25倍に向上している。また、NVIDIA B300は、大規模学習を効率化し、学習性能はH200比で最大4倍に向上。GPUメモリ容量や帯域幅など主要性能が大幅に強化され、ワットあたりの性能も向上している。推論性能についても、H200比で11倍に向上し、FP4対応によりVRAM使用量を削減しつつスループットを改善している。これにより、大規模モデルの学習をより高速かつ省電力で実行可能になる。

ネットワーク構成は、8基のNVIDIA ConnectX-8 SuperNICs(合計6400Gbps)と、複数のGPUを接続・拡張するNVIDIA Spectrum-X Ethernetスイッチによって超高速通信を実現する。低レイテンシー設計により、大規模なAI学習時のデータ転送を高速化し、複数サーバーを組み合わせた分散学習環境でも安定した高性能を発揮する。

提供を開始する「GMO GPUクラウド ベアメタルプラン」では、仮想化レイヤーを介さずGPUに直接アクセスすることで、演算性能を最大限に引き出す完全専有環境を実現する。AI推論処理に特化した演算能力を生かし、大規模言語モデルの高速推論や、エージェント型AI開発など、多様なワークロードにも適した環境を提供する。また、ベアメタルならではの自由度を保ちつつ、初期設定やネットワーク構築の手間を軽減する仕組みを備える。これにより、ユーザーは構築工数を抑えながら、高いパフォーマンスと柔軟なチューニング性を両立したGPU環境を利用できるとしている。

GMOインターネットは、GMO GPUクラウドを中核としたAIインフラ戦略により、急速に進化するAI・ロボティクス分野の技術革新に貢献していくと説明。今後も最新のAI計算基盤の提供と、顧客のニーズに応じた柔軟なクラウド環境の構築により、日本のAI産業に不可欠な国産AI基盤として、社会と産業のAIイノベーション創出に貢献していくとしている。