特集

NVIDIAネットワーク製品責任者に聞く、AIデータセンター向けネットワークの重要性と将来性

2026年2月4日 06:00

AI時代における半導体産業の勝者がNVIDIAであることは、誰もが認めるところだ。その強みは、強力な並列演算が可能なGPUと、それを汎用演算に利用するソフトウェア的な仕組みであるCUDAだという人は多いが、実はNVIDIAの強みはそれだけではない。

NVIDIAの強みは、CUDAの特性の1つである、複数のGPUをまとめて1つのGPUとして扱える点だ。場合によっては数十万基のGPUを1つのGPUとして演算処理させ、AI学習や推論の性能を際限なく引き上げることができる。

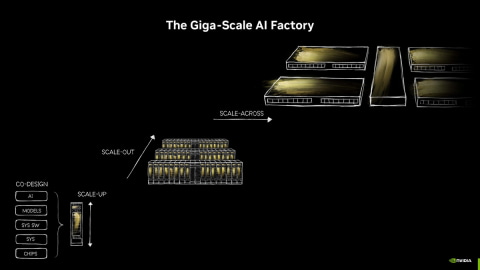

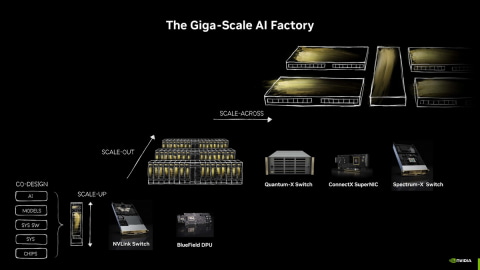

さらに、スケールアップ(主にラック内でのクラスター化)やスケールアウト(ラック間のクラスター化)といった従来の手法に加え、スケールアクロス(クラスターのさらなるクラスター化)など、さまざまなクラスターを実現するためのネットワークコントローラも自社で提供しており、それがNVIDIAのもう1つの強みになっている。

今回本誌では、そうしたNVIDIAのネットワーク製品事業の責任者であるNVIDIA ネットワーキング担当 上級副社長 ギラッド・シャイナー氏にインタビューする機会を得たので、NVIDIAのネットワーク製品の特徴や、この半年でリリースされた新製品の特徴などを紹介していく。

NVIDIAのGPUがAI学習で採用されているのは、CUDAで何基でも巨大な1つのGPUとして扱えること

AIを演算する装置として、特に学習(Training)に関しては、事実上NVIDIA GPUの独占になっている状況に異を唱える人は少ないだろう。AMDの採用例も徐々には増えているが、AIモデルを開発するソフトウェアベンダーのオンプレミス環境、4大CSP(AWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure)などのハイパースケーラーがAI学習のために用意しているインフラのほとんどは、依然としてNVIDIA GPUだ。

AI学習にGPUが採用される最大の理由は、英語で言うところのスケーラビリティ、日本語にすると伸縮自在なアーキテクチャを採用していることにある。というのも、AIモデルを構築するには膨大な量のデータを利用して学習させる必要があるからだ。これには膨大な時間がかかるため、少しでも時間を短縮したい研究者たちが、従来はCPUで行っていた演算をGPUに切り替えたのは2010年代半ばのことだ。

そこから10年以上が経過し、AIのモデルは巨大になるばかり。その結果、学習にかかる時間はさらに増えるようになり、少しでも時間を短縮するソリューションが求められ、GPUを複数連結して処理するという、GPUを汎用演算に利用する際の特徴が利用されるようになった。

NVIDIAは、GPUを汎用演算に利用する「CUDA」を2006年に導入した時に、複数のGPUを利用して塊(クラスター)として利用できる仕組みを採用し、プログラムから演算処理要求を複数のGPUに割り当てて実行できるような仕組みにしている。これにより、GPUが1基であろうが、8基であろうが、72基であろうが、512基であろうが、ソフトウェアからは1つのGPUがあるように見え、ソフトウェア開発者がハードウェアに関して詳しかろうが詳しくなかろうが、GPUの数を増やせば増やしただけ性能が向上するようになっている。

ただし、それはソフトウェアから見た時の話で、ハードウェアの視点で見ると、性能を低下させないようにするには、GPUとGPUを接続するインターコネクトやネットワークの性能が重要になってくる。それらの性能が低いと、「GPUがインターコネクトやネットワークの先にある、ほかのGPUの処理が終わるまで待たないといけなくなり、その間GPUはただ待っているだけになる」(シャイナー氏)との言葉の通り、せっかく高価なGPUを導入したのに、データセンターの中でただ置かれているだけの無用のデバイスになってしまう。

そのため、GPUとGPUを接続するインターコネクト、さらにはラックとラックを接続するネットワーク、この2つが、巨大な1つのGPUの性能を引き出す上で重要になってくるのだ。

スケールアップにはNVLinkとNVLink Switchが利用され、Rubin世代の第6世代では3.6TB/秒の帯域幅を実現

一般的にデータセンターでは、ラック内でCPU/GPUを複数接続することをスケールアップ(縦方向の拡張)、データセンター内でラック同士を接続することをスケールアウト(横方向の拡張)と呼び、この2種類の拡張手段が利用されている。

スケールアップには、GPUの内部で利用されている内部バスと同等の性能を実現するインターコネクトが利用されるのが一般的で、NVIDIAの場合は、NVLink(エヌブイリンク)と呼ばれるインターコネクトを提供している。

このNVLinkは、Blackwell世代では第5世代が提供されており、1.8TB/秒の帯域幅が実現されているが、1月のCESで発表された次世代GPU「Rubin」では第6世代へと強化され、帯域幅は第5世代の倍となる3.6TB/秒へと強化される。

このNVLinkでは、スイッチコントローラ(NVLink Switch)が提供されており、複数のインターコネクトから構成されるネットワークを切り替えて活用できるようになる。これにより、理論上はすべてのネットワークでフルの帯域幅を確保でき、効率のよいスケールアップが可能になる(実際には性能低下はあるが)。

ただし、NVLink SwitchのコストはEthernetスイッチなどに比べて高価であり、必要以上にスケールアップすることになると費用対効果が下がってしまうため、ある程度の台数まではNVLinkとNVLink Switchでスケールアップし、その後はInfiniBandやEthernet(現状1ポートで最大800Gb/秒)などでスケールアウトするというのが一般的だ。

現状では、NVIDIA自身の標準的なラックデザインとなるGB200 NVL72、Vera Rubin NVL72のように、CPU36基/GPU72基までスケールアップし、その後はInfiniBandやEthernetなどでスケールアウトするという使い方になる。

スケールアウトにはInfiniBandないしはEthernetを利用、鍵になるのはRDMA

NVIDIAはスケールアウトネットワーク(データセンターのネットワーク定義ではバックエンドネットワークと呼び、外部との接続に使われるフロントエンドネットワークとは区別されている)として、InfiniBandとEthernetという2種類のネットワーク技術を提供している。

InfiniBandとEthernetの違いは、非常にざっくり言うとプロトコルにある。インターネットやフロントエンドネットワークなど、一般的な用途にはEthernetが利用され、HPCのような特化した用途向けにはInfiniBandが作られ利用されてきた。

Ethernetはいわゆるバッファー型のネットワークで、通信相手先に限らずパケットにデータを流していく形になっているが、InfiniBandの方は送る前に通信先と調停してからデータを送る形で、より安定した通信が可能な形になっている。ソフトウェア的にはそうした違いがあるが、ネットワークの物理層に関しては共通で、例えばNVIDIAがスケールアウト向けに提供しているNIC(NVIDIA的な呼び方ではSuperNIC)では、EthernetとInfiniBandの両対応になっている。

こうしたスケールアウトネットワークで最も重要なことは、RDMA(Remote Direct Memory Access)の実装だ。というのも、GPUをスケールアウトネットワークに接続すると、ネットワークを介して接続されている別のGPUと連携しているメモリ上のデータとのやりとりが頻繁に発生するからだ。

NVIDIAでは、「GPUDirect」というRDMA機能を実装しており、スケールアップないしはスケールアウトした時に、CPUやGPUを介在させずに遠方GPUのメモリ上にあるデータへアクセス可能になっている。こうした仕組みを利用しないとCPUやGPUに負荷がかかり、その分演算性能が低下することになるためだ。InfiniBandに関しては標準でこうしたRDMAの機能が実装されており、それが従来、InfiniBandがHPCで使われてきた理由の1つだった。

ただし、InfiniBandを利用するには専用のスイッチが必要になる。このコストが非常に大きく、ハイパースケーラーのようなクラウドサービス事業者などが導入をためらう理由の1つになっていた。

そこで、Ethernet上で利用されるようになったのがRoCE(RDMA over Converged Ethernet、ロッキーと発音する)だ。RoCEにより、遠方GPUのローカルメモリにアクセスする時にEthernet上でRDMAの仕組みを利用可能になり、CPUやGPUへの負荷を大幅に削減できるのだ。RoCEは、現在ではRoCEv2が一般的に実装されており、これを利用することでEthernetをスケールアウトに活用できるようになっている。

まとめると、ピーク性能ではもともとRDMAを実装してきたInfiniBandが有利だが、ほかのネットワークにも使えるという汎用性の観点と、InfiniBandが事実上NVIDIAからしか提供されていないという観点から、費用対効果を考えると、RoCEv2を利用したEthernetが有利という状況になっている。

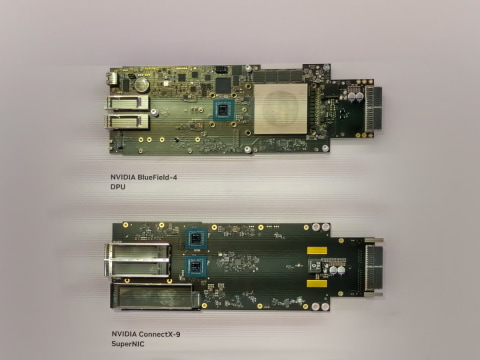

NVIDIAのネットワーク製品、最新製品はConnectX9とBlueField-4

NVIDIAは、こうしたデータセンターのスケールアウト向けネットワーク製品を、イスラエルのMellanox Technologiesを吸収(2019年に買収を完了)したことで得ており、現在NVIDIAが提供しているInfiniBandおよびEthernet製品は、いずれもMellanox由来の製品となっている(今回、話を聞いたシャイナー氏自身も、Mellanox Technologies出身だ)。

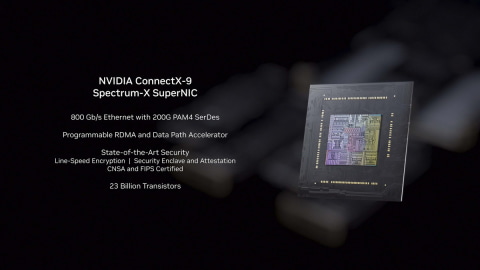

NVIDIAがSuperNICと呼んでいるスケールアウト用のNIC向けには、「ConnectX Spectrum-X SuperNIC」と呼ばれる製品が提供されている。ConnectXはInfiniBandとEthernetの両対応で、どちらのプロトコルを利用した場合でも最大800Gb/秒の帯域幅を実現している。

ほかにも、業界では「ノース・サウス」と呼ばれるネットワークを介したサーバーアクセス向けに、DPU(Data Processing Unit)とNVIDIAが呼称しているBlueFieldも提供。ストレージアクセスなどが発生する際のCPUやGPUへの負荷を軽減し、CPUやGPUが本来の役割を果たせるような仕組みを整えている。また、スイッチ製品も提供しており、Ethernet向けのブランドが「Spectrum-X」、InfiniBand向けのブランドが「Quantum-X」となる。

NVIDIAは、1月に行われたCES 2026において、新CPU「Vera」、新GPU「Rubin」だけでなく、10月に行われた「GTC Washington, D.C.」などのイベントで順次発表されてきたネットワーク関連のチップを展示してアピールしている。

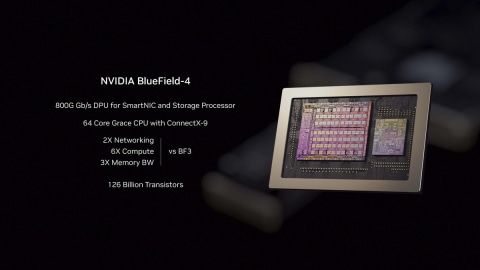

具体的には、第6世代NVLinkに対応した「NVLink 6 Switch」、ConnectX Spectrum-X SuperNICの最新版となる「ConnectX9 Spectrum-X SuperNIC」、BlueFieldの最新版となる「BlueField-4」、Spectrum-Xにシリコンフォトニクスの機能を追加した「Spectrum-X Ethernet Co-Packaged Optics」の4つで、VeraおよびRubinと合わせて、NVIDIAのフアンCEOは「次世代のデータセンターを実現する6つの新しいチップだ」と紹介した。

SuperNICとは、簡単に言うとAIデータセンターでスケールアップすることに最適化されたNICで、通常のNICを超えるNICという意味でSuperNICと呼ばれている。RoCEv2のRDMAに対応し、メモリ転送を効率よく行えることが特徴だ。

NVIDIAのシャイナー氏は、「ConnectX9 Spectrum-X SuperNICは、帯域幅が2倍になっている。ConnectX8世代ではGPUあたり800Gb/秒だったものが、ConnectX9世代ではGPUあたり1.6Tb/秒に強化された。さらに、スケールアウトネットワーク向けに異なるタイプの転送プロトコルに対応するなど、新しいAIアルゴリズムへの対応が入っている。それにより、大規模カスタマーが自分のアプリケーションに応じてプロトコルをカスタマイズできる。また、セキュリティエンジンも強化されており、暗号化の機能が追加され、さらに、RDMAなどのネットワーク設定を学習向けにするか推論向けにするかを、プログラマブルなユニットを利用して最適化でき、リアルタイムにそうした複数のオプションを実行できる」と述べ、GPUあたりの帯域幅が倍になっているほか、RDMAの機能をより強化するためのプログラマブル機能が入っていることが大きな強化点だと説明した。

そのConnectX9向けのASICとGrace CPUがパッケージ上でチップレットとして構成されているBlueField-4に関しては、「BlueField-3では、NVIDIAはArm CPUとConnectX7を1つのSoC(筆者注:ダイとして1つであるという意味)として提供してきた。しかし、BlueField-4では、1つのパッケージ上にArm CPUであるGraceとConnectX9をチップレットの形で混載することを選択した。これは、より製品の自由度を高めるための選択で、例えば将来のバージョンではGraceをVeraにするといったことが可能になる。SoCとして1チップにすると、チップそのものの設計を見直す必要があり、そうした自由度がないからだ。もともとBlueFieldシリーズは、『ノース・サウス』と呼ばれるネットワークを高速化するためのものだったが、BlueField-4世代ではそれをストレージティアにも拡張していくというのがわれわれの考え方だ。『ノース・サウス』のためのプロセッサーだけでなく、ストレージのためのプロセッサーでもあるということだ。このため、われわれは6倍のコンピュート性能、3倍のメモリ帯域という性能強化を行った」と述べ、BlueField-4は、今注目度が高まっているAIデータセンター向けの高性能ストレージの性能を引き出すためにもあるのだと強調した。

次のステップはシリコンフォトニクス導入による消費電力削減とスケールアクロス

NVIDIAのシャイナー氏によれば、NVIDIAのネットワーキング製品における次のステップは、シリコンフォトニクスの実現と、NVIDIAが「スケールアクロス(Scale Across)」と呼んでいる、AIデータセンター同士を接続する場合に利用されるような、データセンター間を効率よく接続するネットワーク環境の実現だ。

シリコンフォトニクスとは、ASICそのものや、チップレットとしてASICのパッケージ上に光通信をデジタル信号に変換する機能を搭載する取り組みのこと。2000年代からネットワーク関連のシリコンベンダー各社が取り組んできた技術だが、これまでは研究開発の段階にとどまっており、実際の製品に適用された例はほとんどない技術だった。

しかし現在では、NTTグループが主導して開発の取り組みが進んでいるIOWN(アイオン)という光電融合(シリコンフォトニクスのこと)の取り組みが注目を集めるなどしており、今後のAIデータセンターで必須の取り組みだと見られている。

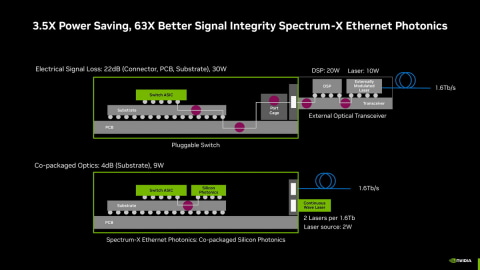

その理由をシャイナー氏は、「今回、我々が2025年の後半に提供開始を発表したSpectrum-X Ethernet Photonicsを利用すると、信号品質が63倍良くなるのに、消費電力は約30%に削減できる」と述べ、シリコンフォトニクスに対応するメリットは、シンプルに消費電力の削減だと説明した。

シャイナー氏によれば、現状ネットワークチップが光通信を行う場合には、独立した外部の光トランシーバーを利用してデジタル信号を光信号に変換しており、光トランシーバーではDSPと変調レーザーを利用して光信号へと変換している。その時に、DSPが20W、変調レーザーが10Wと合計で約30Wの電力を消費しているという。それをシリコンフォトニクスに置きかえることで、シリコンフォトニクスが7W、外部の連続波レーザーが2Wと、合計約9Wで実現可能になるという。つまり、必要な消費電力が1/3以下になるのだ。

現在、AIデータセンターの消費電力が大きな問題になっており、Oracle、ソフトバンクなどが取り組んでいるStargateのデータセンターでは、データセンター1つの消費電力が1.5GWにも達すると明らかにされている。これは、原子力発電所1つ分よりも多い消費電力で、すでに問題になり始めているが、今後さらに消費電力が増えていくと、グローバルで社会問題になる可能性すらあるといえる。その意味で、その消費電力で大きな割合を占めているネットワーク周りの消費電力が1/3になると考えると、インパクトは非常に大きい。

NVIDIAは、シリコンフォトニクスを利用したInfiniBand向けのスイッチ製品として「NVIDIA Quantum-X InfiniBand Photonics」を、Ethernet向けのスイッチ製品として「Spectrum-X Ethernet Photonics」を同時に発表しており、それらの提供を開始することで、シリコンフォトニクスの普及を促進し、同時にAIデータセンターの電力効率を高めていく戦略となる。

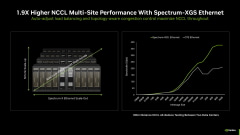

また、その先には「Spectrum-XGS Ethernet」と呼ばれる、AIデータセンターとAIデータセンターを接続するために最適化されたネットワーク製品も用意されている。それにより、2つのデータセンターを接続した時のスループットが約1.9倍となり、複数のAIデータセンターを束ねて1つの巨大GPUとして使うなどの用途における性能を引き上げる。

ここまで見てきたように、NVIDIAはAIデータセンター向けのネットワークソリューションで、EthernetだけでなくInfiniBandも選択肢として用意するなど、多彩なソリューションを提供しており、競合他社をリードしている状況だ。

競合他社も、RDMAの機能を強化したEthernetの標準規格としてUltra Ethernetの規格を策定し、それに対応した製品を投入するなど対抗策を打ち出しているが、NVIDIAほど幅広く製品を提供できていないのが現状と言える。

その意味で、シリコンフォトニクス製品を他社に先駆けていち早く提供できたことは別のリードにつながるといえる。また、今後AIデータセンター同士を接続して性能を上げることも予想される中で、スケールアクロスに対応したソリューションも強みになる可能性がある。

スケールアウト/スケールアクロスといった、より大規模なGPU環境におけるNVIDIAのリードは続いていくことになりそうだと感じたことを付け加えて、この記事のまとめとしたい。