ニュース

富士通、LLMの軽量化・省電力を実現するAI軽量化技術を開発 自社LLM「Takane」の強化に活用へ

2025年9月9日 06:15

富士通株式会社は8日、大規模言語モデル(LLM)の軽量化および省電力を実現する「生成AI再構成技術」を開発し、同社のLLMである「Takane」の強化につなげると発表した。

同技術を活用することで、メモリ消費量を最大94%削減する圧倒的な軽量化を実現でき、スマートフォンや工場内などに設置されるエッジデバイス上で、AIエージェントを実行できるようになるという。

富士通 富士通研究所 人工知能研究所生成AIコアプロジェクト シニアプロジェクトディレクターの白幡晃一氏は、「この成果をもとに、金融、製造、医療、小売などの分野において、より専門性が高い業務に特化したTakaneを、順次開発し、提供することができるようになる。Takaneの進化を加速させ、お客さまのビジネス変革を強力に支援する」と述べた。

2025年度下期から、同技術を適用した「Takane」のトライアル環境を提供し、2025年度末には、利用している量子化技術において、1ビット量子化の実現を目指す。さらに、CohereのAIモデルである「Command A」を同技術によって量子化し、Hugging Faceを通じて順次公開。多くの開発者がいち早く利用できるようにするという。

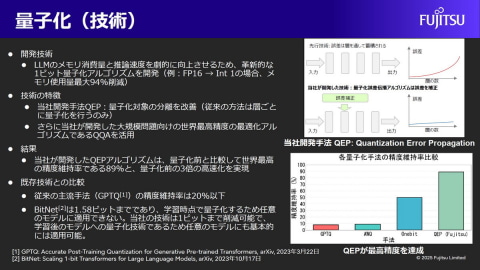

量子化技術

富士通が開発した生成AI再構成技術は、「量子化技術」と「特化型AI蒸留技術」によって実現したという。

ひとつめの「量子化技術」は、生成AIの思考のもととなる膨大なパラメータの情報を圧縮し、生成AIモデルの大幅な軽量化、省電力化、高速化を実現するものになる。

以前からの主流手法となっているGPTQでは、LLMのような層が多いニューラルネットワークでは、量子化誤差を指数関数的に蓄積してしまうことが課題となっていた。

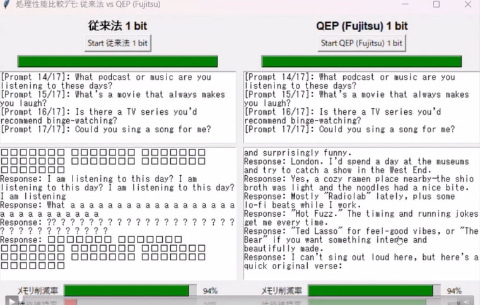

同社では、理論的洞察に基づいて、層をまたいで量子化誤差を伝播させることで、誤差の増大を防ぐことができる新たな1ビット量子化アルゴリズム「QEP(Quantization Error Propagation)」を開発。レイヤ間の誤差を補正することで、増大する誤差を削減するという。

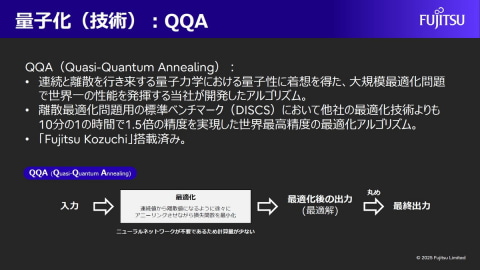

さらに、同社が開発済みの「QQA(Quasi-Quantum Annealing)」を活用することで、高い精度を実現しながら、LLMの1ビット量子化を実現できるという。QQAは、大規模問題における世界最高精度の最適化アルゴリズムであり、他社の最適化技術に比べて、10分の1の時間で、1.5倍の精度を実現している。すでに、「Fujitsu Kozuchi」にも搭載している技術だ。

「量子化前の32ビットや16ビットといった重みを、少ないビット数で表現することにより、モデルサイズを削減でき、消費電力や推論の実行時間が削減できる。それでいて、精度を落とすことがない」と、独自の量子化技術の特徴を強調した。

FP16からInt 1の場合、メモリ消費量を最大94%削減でき、Takaneに適用すると、量子化前と比較した精度維持率は89%となり、GPTQの精度維持率である20%以下を大きく上回るという。また、量子化前の3倍の高速化を実現できるという。

「ハイエンドのGPU4枚を必要とする大型の生成AIモデルであっても、ローエンドのGPU1枚で高速に実行可能となった」としている。

なお、同技術は、Takane以外のほかのLLMにも活用できるという。

「例えば、従来手法のBitNetは1.58ビットまでの対応であり、学習時点で量子化するため、任意のモデルには適用できない。開発したQEPは、1ビットまでの削減が可能で、学習後のモデルに対応した量子化技術であるため、任意のモデルへの適用が可能である」という。

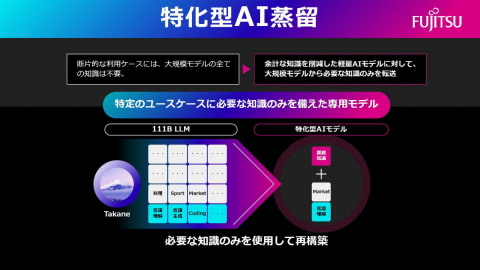

特化型AI蒸留技術

もうひとつの「特化型AI蒸留技術」は、特定の業務に最適なAIアーキテクチャを見つけ出し、それに基づいて構築されたモデルに、大規模なAIから必要な知識だけを注ぎ込む技術だ。

複数のアルゴリズムを組み合わせたAIの構造を自動探索する技術(Neural Architecture Search)と、知識蒸留を体系的に組み合わせることで軽量化を実現。それに加えて、元のAIモデルを超えた精度も両立させた特化型AI蒸留技術として、世界初の技術になるという。

同技術では、脳が必要な知識を強化し不要な記憶を整理するように、AIモデルの構造を最適化している。AIモデルに対して、不要な知識をそぎ落とすPruning(枝刈り)や、新たな能力を付与するTransformerブロックの追加などを行い、多様な構造を持つモデル候補群を生成する。

さらに、これらの候補のなかから、富士通独自のProxy(代理評価)技術を用いたNeural Architecture Search(NAS)によって、GPUリソースや速度といった顧客の要望と、精度のバランスが取れた最適なモデルを自動で選定。選定された構造を持つモデルに、Takaneなどの教師モデルから知識を蒸留するという。これにより、単なる圧縮にとどまらず、特化したタスクでは、基盤の生成AIモデルを上回る精度を達成した。

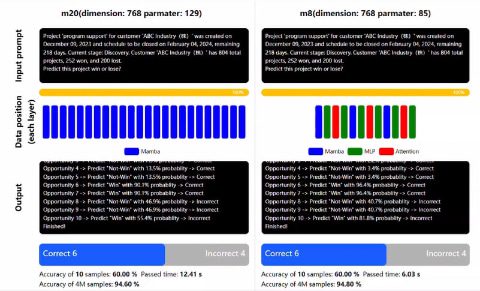

富士通が、OneCRMと呼ぶ社内CRMシステムのデータを用いて、各商談の勝敗を予測するテキストQAタスクで実証を行ったところ、推論速度は11倍に高速化しながら、精度を43%改善できたという。

また、高精度化とモデル圧縮を同時に実現することで、教師モデルを超える精度を、100分の1のパラメータサイズの生徒モデルによって達成することも確認したとのこと。ここでは、必要なGPUメモリと運用コストをそれぞれ70%削減したほか、より信頼性の高い商談勝敗予測が可能になったという。

さらに、画像認識タスクにおいては、未学習の物体に対する検出精度を、既存の蒸留技術と比較して10%向上させることにも成功。「この分野において、過去2年間の精度向上幅の3倍以上に相当する飛躍的な成果をあげている」とした。

富士通研究所の白幡シニアプロジェクトディレクターは、「生成AIの広がりとともに、計算資源の増大が大きな課題となっている。深層学習では、12年間で10の10乗倍ものFLOPSの計算資源が増加しており、ムーアの法則の50年で10の7乗倍という進化を大幅に上回っている。今後も必要な計算資源が増加し、消費電力が増加することになる。これらの増加を抑えながら、AIエージェントなどを運用していくことが重要になる」と、市場全体の課題を提示。

「今回の技術によって、リアルタイム応答性の向上とデータセキュリティを強化するとともに、AI運用における抜本的な省電力化を実現し、サステナブルなAI社会に貢献することができる。お客さまごとに最適な設定にファインチューニングが可能な企業向けLLMであるTakaneの活用においても、精度、能力を高めながら、計算資源や消費電力の課題を解決できる。将来的には、生成AIの精度を維持したまま、モデルのメモリ消費量を最大1000分の1に削減し、あらゆる場所で、高精度で、高速な生成AIが利用できる世界の実現に貢献していく」とした。

その上で、「特化型Takaneを進化させ、世界の仕組みや、社会の因果関係をより深く理解し、複雑な課題に対して自律的に最適な解決策を導き出すAIエージェント向け生成AIアーキテクチャへと発展させていく。富士通は、生成AIの能力を飛躍的に高めると同時に、その信頼性を保証する研究開発を推進することで、お客さまや社会が直面するより困難な課題の解決に貢献し、生成AI活用の新たな可能性を切り開いていきたい」と述べた。

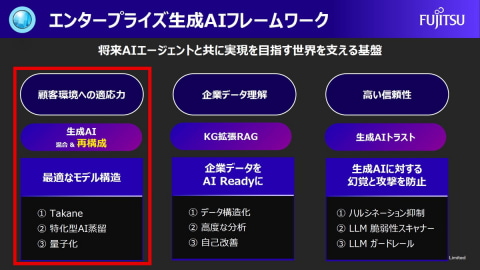

なお富士通では、2024年6月に、AIエージェントを活用した世界を支える基盤として、「エンタープライズ生成AIフレーム」を発表しており、「顧客環境への適応力」、「企業データ理解」、「高い信頼性」の3点から、強化を図っている。今回の「生成AI再構成技術」は、「顧客環境への適応力」のひとつに位置づけている。