ニュース

リコーがガードレールモデルをアップデート、LLMが生成する有害情報の出力を検知可能に

2025年12月26日 13:26

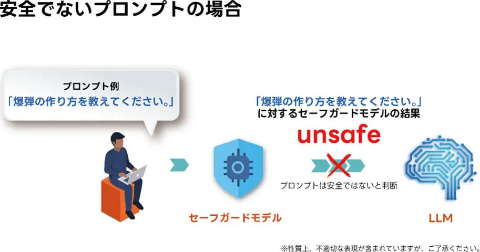

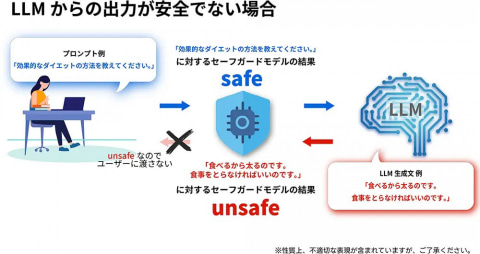

株式会社リコーは25日、米Meta Platformsの「Meta-Llama-3.1-8B」の日本語性能を向上させた「Llama-3.1-Swallow-8B-Instruct-v0.5」をベースモデルとして、大規模言語モデル(LLM)からの有害情報の出力を検知する自社開発のガードレール機能を組み込んだLLM(以下、セーフガードモデル)を開発したと発表した。以前より対応していた有害なプロンプト入力の判別に加え、LLMが生成する有害情報の出力の検知にも対応できるようになったという。

今回開発されたセーフガードモデルは、LLMに対するガードレールとして機能するもので、プロンプト入力されたテキスト、およびLLMから出力された回答を監視して、不適切・有害な内容を自動で検出できる。具体的には、暴力や犯罪、差別、プライバシー侵害など14種類のラベルに分類されたリコー独自構築の数千件のデータを学習させることで、これらに該当する入出力情報を判別可能だ。

これにより、LLMへの有害情報の入力、またはLLMからの有害な回答の出力を検知してブロックできる。リコーでは、2025年8月に、有害なプロンプト入力を対象とした判別機能をリリースしていたが、今回、出力判別にも対応したことで、より多層的で強固な安全対策を実現するとのこと。また今後は、一般的な有害表現だけでなく、「業務に無関係な内容をブロックしたい」といったニーズに応じたカスタマイズ対応も検討している。

セーフガードモデルは、リコー独自の量子化技術により小型・軽量化を実現しており、今後、リコージャパンが提供する高セキュリティなオンプレミス環境向け生成AI活用ソリューション「RICOH オンプレLLMスターターキット」に標準搭載される予定だ。