イベント

クラウドインフラ運用技術者の祭典「Cloud Operator Days Tokyo 2025」、AIと運用技術の最前線を今年もレポート

2025年9月8日 06:00

クラウドインフラ運用技術者のための年次カンファレンスイベント「Cloud Operator Days Tokyo 2025(CODT2025)」の、基調講演を含むクロージングイベントが、9月5日にオフラインで開催された。会場は、東京・お台場の「docomo R&D OPEN LAB ODAIBA」。

今年のCODTのテーマは「運用者に光を! ~創る運用、遺す運用~」。イベントは7月15日から各セッションをオンデマンドで配信してきた。そしてクロージングイベントでは、その中から選ばれたものがリアルセッションとして実施された。なお、オンデマンドセッションは9月19日まで見ることができる。

クロージングイベントでは、午前中にオフライン版セッションを実施し、午後には基調講演やパネルディスカッションが行われた。また、オンラインで配信された中から優れたセッションを選考し表彰する「輝け!クラウドオペレーターアワード2025」の発表と授賞式も行われた。

Interop Tokyo ShowNetの構築と運用に生成AIチャットボットはどのぐらい役に立つか実験

基調講演「2025年のShowNetに見る、ネットワークにおける生成AI活用の現在地」では、東京大学 情報基盤センターの中村遼氏が登壇。ネットワーク技術のイベント「Interop Tokyo」の会場に設置される大規模で最先端のネットワーク「ShowNet」において、今年、運用に生成AIを導入した実験について解説した。

実験の動機として、コーディングにおいて生成AIが使われるようになってきており、ネットワーク運用にも使えるのではないかと考えた、と中村氏は語った。

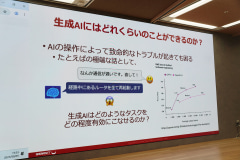

とはいえ、「なんか通信が遅いです。直して」という指示に、「ルーターをすべて再起動します」では困る。どのようなタスクをどの程度有効にこなせるかを見極める必要があったためだ。

参考として、コーディングにおけるOpenAIのベンチマークでは、GPT-5が約7割の正答率を出すというデータを中村氏は紹介した。

そこで、6月に開催された「Interop Tokyo 2025」のShowNetでネットワーク構築・運用支援実験を実施した。ShowNetでは、のべ828名が参加し、ラック20本強の機材を使って、超複雑なネットワークを相互接続検証しながら約12日間で構築する。

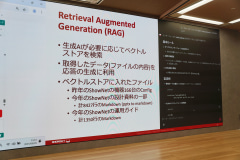

実験としては、Azure AI Serviceとgpt-4oでチャットボットを実装した。ここにチケットシステムと、ベクトルストアによるRAG、ネットワーク機器を操作するMCPサーバーを接続した。

RAGではベクトルストアに、昨年のShowNetの機器166台のconfigと、今年のShowNetの設計資料の一部、今年のShowNetの運用ガイドを格納。例えば、「ルーターのインターフェイスに設定するdescriptionはどうすればいいの」と聞くとガイドラインを答えてくれるようにした。

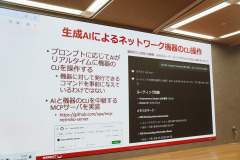

またMCPによるネットワーク機器の操作では、チャットボットへのプロンプトによって、例えば機器の状態を確認できるようにした。

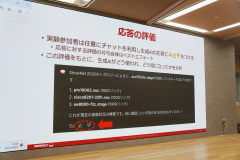

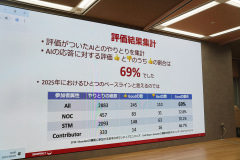

チャットボットの実験には100名以上のネットワークエンジニアが参加し、生成AIの応答に対して高評価または低評価をつけた。

その結果、高評価の割合は69%で、「AIの回答はだいたい7割が役に立つ」というのが2025年におけるひとつのベースラインと言えるのではないかと中村氏は語った。

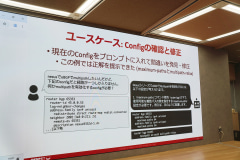

ユースケースとしては、まず、configについて書き方を質問する例がある。この例では、生成AIが裏でベクトルストアを検索したりルーターにログインしたりして、正しいconfigを教えてくれた。

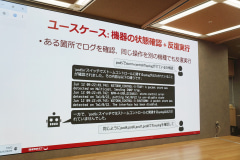

次のユースケースとしては、機器の状態確認と反復実行がある。あるPod(中継拠点)のログについて生成AIに確認するよう指示したあと、同じようにほかのPodについても実行させたというものだ。Podごとに機器のベンダーや機種が異なるため同じコマンドは使えないが、生成AIは同じ操作を異なるコマンドで実行した。

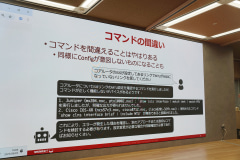

一方で生成AIのミスもあった。MTU設定を確認するよう指示したプロンプトに対し、生成AIが間違ったコマンドを実行してエラーになった。これについて中村氏は「プロンプトの指示も少し不親切だった」と補足した。

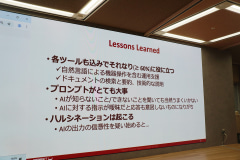

こうした結果から学んだこととして中村氏は、各ツールも込みでそれなりに役に立つこと、プロンプトの指示内容がとても大事なこと、ハルシネーションは起こることの3つを挙げた。そのうえで「でもこの“AI”を“人間”に変えても同じ。確率で動くAIとの付き合い方は、確率で動く人間と同じ」と付け加えた。

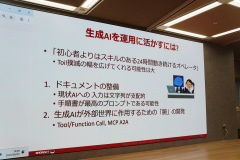

そして2025年の現在地では、ネットワーク運用における生成AIは、「初心者以上、達人未満」だとした。知識とスループットは人間より上だが、トラブルシューティングにおける推論能力は、まだ熟練したオペレーターのほうが上だと語った。

特に、24時間動き、スキルは初心者より上であることから、SREなどで言われるトイル(骨折り仕事)の削減の幅を広げてくれる可能性は大きいと述べた。

そして、生成AIを運用に活かすには、人間が作業できる手順書などAIが参照できるドキュメントの整備が大事であることと、MCPなど外部世界に作用するための“腕”の開発が必要であることを中村氏は挙げた。

さくらインターネットのAIスパコンで、LLMの分散学習ジョブをベンチマークした結果

基調講演「AIスパコン『さくらONE』のLLM学習ベンチマークによる性能評価」では、さくらインターネット株式会社の坪内佑樹氏が登壇。同社のAIスパコン「さくらONE」で、LLMの分散学習ジョブの性能を評価してみた結果を紹介した。

同氏は、さくらインターネット研究所において、テレメトリーとAIOpsを研究しているという。講演の趣旨は「SREがはじめてスパコンでLLMの分散学習ジョブを流して性能評価してみたことから、数百基のGPUを用いたLLM学習のパフォーマンスエンジニアリングがどんな感じかを伝える」というもの。

坪内氏はまず、分散学習とAIスパコンの概要を解説した。

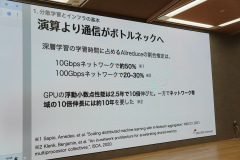

LLMなどの深層学習はバッチ型のワークロードで、高速化するために、データやモデルの並列化がなされる。ここで、並列化によって演算よりも通信がボトルネックになるという。GPU製品は短い期間で高速化するが、ネットワーク帯域の伸長は遅いためだ。

このネットワーク通信の高速化のために、NICにメモリ転送をオフロードするRDMA技術が使われている。これには、RDMAをネイティブサポートしたInfiniBandや、イーサネットベースのRoCE v2がある。

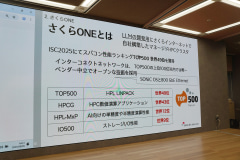

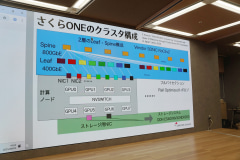

そうした中で、さくらインターネットが自社構築したLLM開発用HPCクラスタが「さくらONE」だ。HPCのカンファレンス「ISC2025」において、スパコン性能ランキングTOP500で、世界49位を獲得した。

特徴としては、インターコネクトに800GbEと、オープンソースネットワークOSのSONiC OSを採用しており、SONiC OSを採用しているのはTOP500の上位100位以内では唯一だという。

システム概要としては、CPUコアが12000個、GPUが800基、800GbEネットワーク、2PBのLustre FSストレージを備えている。ネットワークはリーフスパイン型のRail Optimizedトポロジー構成で、スパインが800GbE、リーフが400GbEだ。

さて、さくらONEで分散学習ベンチマークを実施した動機について、TOP500は一般の計算機性能を計測するのに対し、さくらONEの主用途であるLLM学習における性能を計測したいと考えたと坪内氏は説明した。

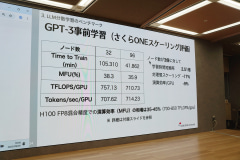

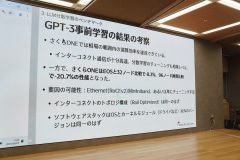

ベンチマーク指標としては、MLPerfベンチマークスイートから、GPT-3 175B事前学習とLlama2ファインチューニングを選択した。今回の内容はこの前者についてだ。

インフラのベンチマークなので、モデル側のパラメータは固定し、学習終了条件を指定して、学習開始から終了までの時間を計測した。

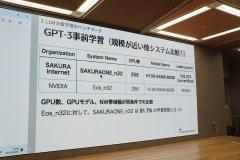

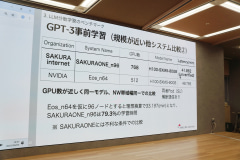

結果のスコアとしては、7種類の中で、NVIDIAのEosの11,616 GPU(Eos-dvw_n1452)が1位で、さくらONEの768 GPU(SAKURAONE_n96)が4位となった。

GPUが多ければ速くて当然なので、規模の近いシステムの比較として、さくらONEの256 GPU(SAKURAONE_n32)とNVIDIA Eosの256GPU(Eos_n32)をピックアップすると、さくらONEの性能はEosの91.7%ほどで、下回る結果だったという。

また、さくらONEの768GPU(SAKURAONE_n96)とNVIDIA Eosの512GPU(Eos_n64)をピックアップし、結果にGPU数の比を掛けて比較したところ、さくらONEの性能はEosの79.3%ほどで、下回る結果だったという。

さらにスケーリング評価では、GPU数が3倍になった時に学習時間短縮率が2.51倍と、やや線形に増えていないが、演算効率(MFU)はおおむね相場の範囲という結果となった。

以上の結果の考察として坪内氏は、演算効率は相場の範囲内だが、NVIDIA Eosと比較すると性能が落ちることをまとめた。Eosとの差については、RoCE v2とInfiniBandの差にしては大きな差であることから、チューニング不足なのではないかという可能性が語られた。

「輝け!クラウドオペレーターアワード2025」発表

「輝け!クラウドオペレーターアワード2025」は、全セッションの中から優れたセッションを表彰するものだ。その意図として、CODT2025実行委員長の長谷川章博氏(AXLBIT株式会社)は、発表して終わりではなく表彰することで、イベントのテーマのように「運用者に光を」あてるものだと説明した。

授賞式では、審査委員会が選んだ「最優秀オペレーター賞」「審査員特別賞(変革編)」「審査員特別賞(挑戦編)」と、実行委員会が選んだ「実行委員会特別賞」、視聴者の人気(再生数)から選んだ「オーディエンス賞」、若手発表者を表彰する「ヤングオペレーターアワード」が発表された。

なお、審査委員会に筆者も参加していることをお断りしておく。

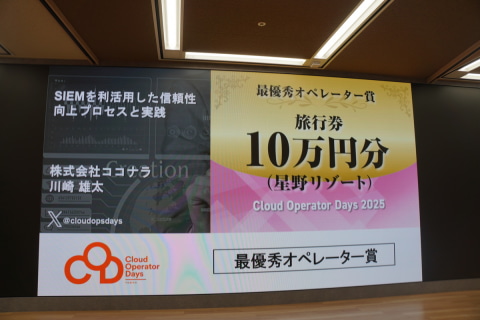

最優秀オペレーター賞

最優秀オペレーター賞には、株式会社ココナラの川崎雄太氏による「SIEMを利活用した信頼性向上プロセスと実践」が選ばれた。

Webのサービスにおいて、少人数のチームでセキュリティ対応するのにあたり、SIEM(セキュリティ情報イベント管理)によるセキュリティログ分析によって、システム全体の健康状態がわかりプロアクティブな対応ができるようになったという発表だ。少人数で対応するために、CSIRTチームとインフラ・SREチームで共同してあたったことにより、セキュリティとSREとの掛け算となったことも語られた。

講評では、少人数でがんばったことや、セキュリティ分析によって得られた知見の例が紹介された点などにより、審査委員会でも異論なく決まったと語られた。

受賞コメントとして川崎氏は、SIEMをSREとセキュリティ組織が利用した話であり、SREとCSIRTが分業してどのようにがんばったかをセッションにまとめたので、会社の規模にもよるが参考になると思っていると語った。

審査員特別賞(挑戦編)

審査員特別賞(挑戦編)には、KDDI株式会社の松本健太郎氏と盧新杰氏による「俺たちの障害対応訓練 - チーム全員が動ける!障害対応フロー作成と訓練の実践」が選ばれた。

運用チームが人事異動によりメンバーが大きく入れ替わることになった時に、運用ノウハウを棚卸ししてドキュメントなどにまとめ、さらにその内容から障害対応訓練を実施することで伝授したという発表だ。

講評では、ピンチを機に運用ノウハウをまとめたことが「創る運用、遺す運用」の挑戦となったことや、障害対応訓練について内容やポイントなどが赤裸々に語られて聴講者の参考になりそうなことが評価されたと語られた。

受賞コメントとして松本氏と盧氏は、地道に役立つと考えて改善してきたことを、聴講者の皆さんが「自分たちも取り入れられる」と思える形で届けられれば、と語った。

審査員特別賞(変革編)

審査員特別賞(変革編)は、クラウドエース株式会社の髙橋和真氏と三原知樹氏による「「さらばアラートノイズ!」AIエージェントでインシデント対応を自動化する」が選ばれた。

優先度が低いアラートによって人間の時間が奪われる問題に対し、ADK(Agent Development Kit)で一次対応のAIエージェントを開発したという発表だ。そのAIエージェントの設計や利用例、開発中にハマったこと、AIエージェントの運用管理などについても説明された。

講評では、CODTでは年ごとにテーマのトレンドがあって今年のトレンドはAIであること、その中でこのセッションは運用に欠かせないアラートについて、AIによるアラートの最適化を扱っていること、そして発表内容が非常に実践的なものになっていることが評価されたと語られた。

受賞コメントとして髙橋氏と三原氏は、24時間365日で運用をする中でインシデントを受け取って対応する人間の負荷が命題となっており、AIエージェントを開発したことでだいぶ緩和されたと語った。

実行委員会特別賞

実行委員会特別賞には、NTTコミュニケーションズのKazuki Sato氏による「働く部屋を快適に!k8sで構築する環境モニタリングシステムと実践ダッシュボード運用術」と、日本電信電話株式会社(現NTT)の渡邊拓磨氏による「GitHub Actions+K8s新機能で虎の子のGPUを使い倒す一案」の2セッションが選ばれた。

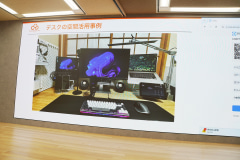

「働く部屋を快適に!k8sで構築する環境モニタリングシステムと実践ダッシュボード運用術」は、自宅ラックのKubernetesクラスタで、温度やCO2濃度などのモニタリングシステムを構築したという、今年新設された「ワークハック」部門の発表だ。

講評では、自宅でKubernetesを動かして各種センサーを組み合わせ、ダッシュボードも用意して、作っただけでなく使っているところが評価された。

受賞コメントでSato氏は、完全に趣味の発表だが、その中に皆さんの役に立つようにしたと語った。

「GitHub Actions+K8s新機能で虎の子のGPUを使い倒す一案」は、ハイエンドGPUは貴重だが需要も高い中で、CI/CD基盤でのGPU実行環境の払い出しを、KubernetesのDRA(動的リソース割り当て)の機能を使って実現するというアイデアの発表だ。

講評では、限られたGPUの効率利用が共通の課題となってくる中で、プルリクエストを起点としたアーキテクチャを作ったことが、今後GPUを運用する人のひらめきの種になることが評価された。

受賞コメントで渡邊氏は、講評を受けて、GPUが課題になる会社もある中で、このセッションがひらめきにつながり、刺激になれば本望だと語った。

オーディエンス賞

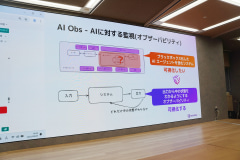

オーディエンス賞には、Datadog Japanの角田高彬氏による「AIエージェントの実運用を支えるオブザーバビリティの実践」が選ばれた。

AIエージェント自体の運用の課題と、それを同社のオブザーバビリティプラットフォームで解決する方法を中心に紹介するセッションで、AIエージェントとオブザーバビリティについての基礎と実践におけるポイントも解説された。

講評では、AIエージェントとオブザーバビリティというホットなテーマを扱い、その両者の関係がよくわかるものだったと評価された。

受賞コメントで角田氏は、AIの機能は少し前には実用に使うには手間が多かったが、現在では使える段階に来たと思っていると語り、クリック数だけでなく皆さんのためになる話ができていたらうれしいと付け加えた。

ヤングオペレーター賞

ヤングオペレーター賞には、NTT東日本株式会社の久保田留奈氏による「新入社員が挑戦!アナログ業務を約6か月で自動化した秘訣」と、AXLBIT株式会社の草開新太郎氏による「VMwareからのOpenStack移行戦略:virt-v2vによる実践と運用基盤構築のポイント」の2セッションが選ばれた。

「新入社員が挑戦!アナログ業務を約6か月で自動化した秘訣」は、工事の事前連絡での架電業務をAmazon Connectやサーバーレス関連サービスを使って自動化した体験談のセッションだ。

また、「VMwareからのOpenStack移行戦略:virt-v2vによる実践と運用基盤構築のポイント」は、VMwareのライセンス改訂問題にともなうOpenStack移行について、情報が少ない中でいくつかの方法を検証し環境を構築したことが語られたセッションだ。

講評では、「新入社員が挑戦!アナログ業務を約6か月で自動化した秘訣」について、取り組み内容の掘り下げがしっかり押さえられており、プレゼンもとてもうまいことが評価された。

受賞コメントで久保田氏は、賞をもらえて自分の取り組みに自信が持てたとして、今後も効率化など貢献していきたいと語った。

New Relic、DDN、Datadogが、AI時代のインフラと運用について語る

基調講演では、スポンサー企業の講演も行われた。

New Relic株式会社の「オブザーバビリティの可能性、実践の勘所と成功への支援」では、技術統括 コンサルティング部 ソリューションコンサルタントの松本孝希氏が登壇した。同社のオブザーバビリティプラットフォームと、そのAIによる進化を紹介。さらに、AIOps時代に向けた必要なこととして、システム側の対応や、人・組織・プロセスの準備、そのためのNew Relicによるウェビナーやトレーニングなどのコンテンツを紹介した。

データダイレクト・ネットワーク・ジャパン(DDN)の「生成AIと仮想基盤のストレージ最適解 - 圧倒的なパフォーマンスと運用性を実現するDDNのストレージプラットフォーム -」では、Tintri事業部 シニアシステムエンジニアの八木下洋平氏が登壇した。同社のHPCやAIに向けたストレージ製品がリードおよびライトにおいて「汎用ストレージと1桁違う」ところを紹介。また、2018年に買収して自社製品群に加えた、仮想化専用ストレージのTintriについても説明し、新製品を紹介した。

Datadog Japan合同会社の「DatadogとAI:活用と監視、二つの視点から見るオブザーバビリティ」では、Sales Engineerの角田高彬氏が登壇した。「輝け!クラウドオペレーターアワード2025」のオーディエンス賞を受賞したオンラインでのセッションでの“AI自体の運用”の話と、クロージングイベントのリアルセッションでの“AIによる運用(AIOps)”の話を合わせて、ダイジェストを紹介した。

なお、クロージングイベントでは、この3社によるランチセッションもそれぞれ開催された。

このうちDatadogによる「予測から調査へ、AIエージェントで叶えるAIOpsの未来」では、Sales Engineerの木村健人氏が登壇。前述の“AI自体の運用”話と“AIによる運用(AIOps)”の話のうち、後者のAIOpsにおけるDatadogプラットフォームについて紹介した。

木村氏はAIOpsを、従来のAIOpsと、最近のAIエージェントによるAIOpsに分類し、前者の役割が過去の時系列データからの予測、後者の役割が実障害の監視データを元にした調査だと説明した。そして前者の自社プロダクトとしてWatchdog InsightsやWatchdog RCAなどを、後者の自社プロダクトとしてBits AI SRE AgentやAI Voice Interfaceなどを紹介した。

作業環境で各自が使っているグッズを紹介

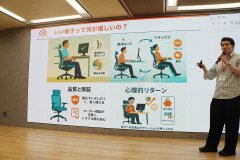

少し変わったセッションとしては、「ワークライフハック ~運用者のための在宅環境アップデート術~」と題して、自宅などの作業環境で各自が使っているグッズを紹介するパネルディスカッションも開かれた。

パネリストには、富士通株式会社の岩松昇氏、NTTの岩本裕真氏、株式会社デンソーの島津直道氏が登場。モデレーターであるレッドハット株式会社の山下祐生氏をまじえ、時には会場からの会話への参加もあり、ガジェット談義が繰り広げられた。

話題は、いす(エルゴノミックチェア)に始まり、キーボード、ポインティングデバイス、ワークデスクの上の配置や配線、オンライン会議のための設備、持ち運ぶグッズと、それぞれに各自のこだわりが語られた。