ニュース

DDNジャパン、AIデータ活用を支援する低遅延・高速ストレージ基盤「DDN Infinia」を販売

2025年9月10日 06:00

HPC(スーパーコンピューターなど)向けストレージ製品を手がける株式会社データダイレクト・ネットワークス・ジャパン(以下、DDNジャパン)は、新たに、AIインフラ用途を想定したデータ基盤「DDN Infinia」の日本での販売と、「DDN AIアプリケーション開発支援プログラム」の提供を9月9日に開始したと発表した。

Infiniaは、一種の高速オブジェクトストレージ(DDNでは「オブジェクトプラットフォーム」と呼んでいる)だ。

特徴としては、ノード追加によって性能と容量をリニアに拡張できることや、10万台を超えるGPUの実環境で実証済みの効率性、コンテナ化されてAmazon Web Services(AWS)・Microsoft Azure・Google Cloud Platform(GCP)をネイティブにサポートすることが挙げられている。

また、POSIXやS3といった従来のストレージインターフェイスのボトルネックを避けつつ、S3データサービスも提供。これは、低レイテンシーとGPU直結RDMAゼロコピーI/Oによる圧倒的なスループットを実現し、オブジェクトサイズやメタデータの制限もないという。さらに、「DDN Infinia SDK」も提供される。

製品はアプライアンスの形態で提供する。パートナーを通じて販売し、11月に出荷開始予定。現在DDNジャパンのInfiniaのページには、Infiniaを搭載したラックマウント型のアプライアンス製品「AI2000」が掲載されている。

一方のDDN AIアプリケーション開発支援プログラムは、AIアプリケーション開発企業によるInfinia活用を支援するもの。InfiniaおよびSDKの無償提供や、開発および検証の無償技術支援、DDNジャパン検証リサーチセンターでの共同検証を含んでいる。

9月9日にはDDNジャパンが、Infiniaを含むAI分野での戦略や取り組みについてのメディアラウンドテーブルを開催した。DDNのストレージ製品はHPC分野で広く使われ、富岳などでも採用されている。こうした特定分野での知名度が高いベンダーということもあり、メディア向けの会見を開くことは少なかった。

しかし近年では、HPCに似た性質を持つ生成AIのインフラ(いわゆるAIスパコン)の分野でもDDNストレージの採用が増えており、この分野での実績や活動を知ってもらいたいと考えてメディアラウンドテーブルを開催したとのことだった。

日本への投資を3年で2倍にし、AIアプリケーション開発でのストレージを支援

まずDDNの戦略と展望について、DDNジャパンの代表取締役社長であるロベルト・トリンドル氏(兼 データダイレクト・ネットワークス グローバルセールス シニア・バイス・プレジデント)が説明した。

トリンドル氏はここ数年のDDNについて、「ニッチなHPCの世界だった技術が、突然、一般的なデータセンターの基本になりつつある」と語った。

現在では生成AIにより、膨大な計算が必要になっている。ここで「最終的なリソースは計算ではなくデータ。データをどう管理するか、どう保管するか、どう分散するかが、全体の効率に影響を与える」とトリンドル氏は言う。

こうした計算は、これまで主に生成AIモデルの学習のために行われてきたため、効率が考えられていなかったとトリンドル氏。しかしこれからは、生成AIモデルを推論(inference)で使うアプリケーションが増えるにつれて、データアクセス速度や電力消費などの効率が課題になるだろうと指摘する。

「今回の製品(Infinia)はそこを重点とした、いままでなかったカテゴリーの製品だ。また、スケーラブルなアプリケーションをサポートできる」(トリンドル氏)。

さてDDNは日本でこれまで、一般的な外資系企業と違い、大手ベンダーとともに仕事してきたという。

それに対して今後は、AIアプリケーション向けに製品を提供していくに伴い、単なるインフラの販売から変える必要があるという。まず、AIアプリケーション開発者と緊密に連携する必要があるほか、SaaSアプリケーションとAIを組み合わせるためにクラウドベースの実証プログラムが必要になるという。さらに、台湾のハードウェアODMベンダーとの連携も必要になるとした。

具体的な日本での施策としては、まず、日本への投資を生成AIを中心に増やし、今後3年で2倍にする。また、AIアプリケーション開発でのストレージを支援できる体制を作るほか、実際のアプリケーションをもとに、クラウドベースの実証プログラムを2026年に開始する。そして、ハードウェアパートナーとの連携を強化するという。

「これにより、これまでHPCで成功してきたのと同じように、生成AIのインフラでも成功していく」とトリンドル氏はまとめた。

HPC由来の「DDN EXAScaler」と新しい「DDN Infinia」――2つのAIインフラ向けストレージプラットフォーム

DDNの生成AI市場への取り組みについては、DDNジャパンのプリンシパルエンジニアの井原修一氏が説明した。

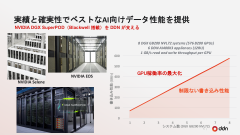

最初に井原氏は、AIインフラに向けたDDNのストレージプラットフォームとして、HPCで培い“枯れている”高効率・スケーラブルな並列ファイルシステム「DDN EXAScaler」と、今回の新しい「DDN Infinia」の2つを紹介した。

まず、AIの学習について説明した。それによると、HPCとAIは、大規模なノードからの同時アクセスや、低遅延・広帯域なネットワークなど、共通要素が多いという。

またAIの学習におけるストレージの用途は、日単位、長い時は月単位にわたるジョブが途中で落ちたときに復帰できるよう、定期的にメモリの情報をスナップショットで保存するというものだ。データサイズが大きくなると書き込む量も膨大になり、高速な書き込みが必要になる。

そしてこの分野では、NVIDIAのAIスパコンでDDN製品を採用しているほか、ソフトバンクや、最先端共同HPC基盤施設(JCAHPC)、さくらインターネットのAIスパコンでも採用されているとした。

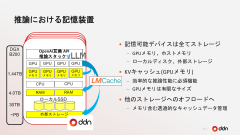

続いて推論(inference)について。LLMの推論では、テキストをトークンに分解し、計算して予測する。ここで、途中の計算結果を保存(キャッシュ)して再利用することで、結果を返すレスポンス時間が短くなる。

この保存先は、GPUメモリ、ホストメモリ、ローカルディスク、外部ストレージと階層化される。これを自動的に階層化して管理するソフトウェアに、オープンソースソフトウェア(OSS)の「LMCache」がある。

DDNではこの外部ストレージとして、DDN Infiniaを使った高速化を検証している。また、同時利用ユーザー数による性能評価や、GPU・メモリバンド幅・メモリ容量のうちいずれかを圧迫するような評価セットなどを、LMCacheコミュニティに貢献していると井原氏は語った。

Infiniaの特徴を解説

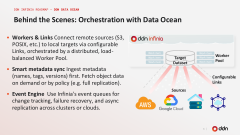

またDDN CTOのスヴェン・オーメ氏は、DDN Infiniaについて、DDN Infinia SDKを中心に解説した。

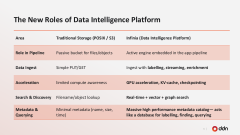

まずオーメ氏は、従来のPOSIX(ファイルストレージ)・S3(オブジェクトストレージ)のストレージと、AIワークロードのストレージとを比較した。

役割としては、従来型のストレージはデータを読み書きするものであるのに対し、AIワークロードではインテリジェントな対応が求められること、従来型のストレージではファイル名やオブジェクト名で対象が探されるが、AIワークロードではベクトル検索やグラフ検索などへの対応も求められることを説明。そこで、従来のストレージでは対応できない要件に向けて、Infinia SDKを開発したとオーメ氏は話す。

高速なデータ処理や、システム内のデータで発生したイベントに対するアクションなどの機能を持ち、HPCで培った技術による高いスケーラビリティも実現しているという。

また、Infiniaの分散データ機能により、エッジで生成されたデータをエッジに保存しつつ、必要なデータのみをデータセンターに移すようなこともできるという。

さらにInfiniaでは、S3やPOSIXといったさまざまなデータソースを統合し、メタデータを同期し、さらにInfiniaのイベントエンジンに組み込むことができるとオーメ氏は説明した。

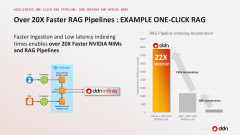

Infiniaの性能の例として、オーメ氏はRAGのパイプラインをAWSで動かしたときの応答時間のケースを紹介した。AWSのネイティブなRAG、AWS S3 Expressを使った実装、そのAWS S3 ExpressをInfiniaに置き換えたものの3つを、アプリケーションの変更は最小限に抑えて比較した。その結果、速度が22倍になり、コストを50%削減したという。

ちなみにこうしたInfiniaの速度のポイントについて、オーメ氏は、S3など通常のストレージではブロックストレージ・RAID・ファイルシステム・オブジェクトストレージといった層が積み重なっているのに対し、InfiniaではInfinia SDKが中間層を省いてドライブに直接アクセスしてKVストア(キーバリューストレージ)として扱っている点を挙げた。

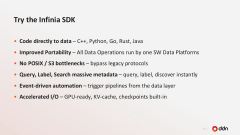

最後にInfinia SDKの特徴をオーメ氏はまとめた。C++やPython、Go、Rust、Javaなどさまざまなプログラミング言語に対応。ソフトウェアベースでポータブル。POSIXやS3のインターフェイスのボトルネックがない。メタデータのクエリやラベルづけなどを並列で高速に実行。そして、GPUやKVキャッシュなどさまざまなレベルでのアクセラレーションを実現していると語った。