イベント

マット・ガーマンCEOが登壇、ソニーやAdobeなど大手顧客もAWS AIを活用して“効率爆上げ”とアピール

AWS re:Invent 2025初日基調講演

2025年12月4日 06:30

12月1日~12月5日(現地時間)に、クラウドサービス事業者AWS(Amazon Web Services)の年次イベント「re:Invent 2025」が、米国ラスベガス市にあるThe Venetian Expoなどの会場で行われている。12月2日午前(現地時間)には、AWS CEO マット・ガーマン氏による基調講演が行われ、AWSが今後導入する新しいサービスや半導体製品などに関する発表が行われた。

ガーマン氏はこの中でAWSの新しいAI学習向けのインフラ、推論向けのマネージドサービス、データベース関連の新サービス、AIエージェント、そしてフロンティアエージェント(いわゆるエージェンティックAIのこと)の5つのテーマにわたって新製品などを紹介した。

また、講演中にはゲストとして、ソニーグループ株式会社 執行役 CDO(デジタル&テクノロジープラットフォーム(デジタルトランスフォーメーション戦略、情報システム、情報セキュリティ、先端技術領域)、R&D、技術戦略、品質マネジメント担当) 小寺剛氏、Adobe CEO シャンタヌ・ナラヤン氏などAWSの顧客企業が登壇し、どのようにAWSのサービスを活用しているかについて説明した。

AWSは最も充実しているクラウドサービスだとガーマンCEO、顧客のおかげと感謝

講演の冒頭でガーマン氏は「re:Inventは今回で14回目の開催となる。オンラインではのべ200万人が視聴し、会場には6万人以上が参加している。AWSのビジネスは順調に成長しており、売上は1320億ドルと前年同期比で20%成長し、昨年だけで220億ドルの成長を見せている。カスタムCPUのGravitonは、AWSが提供しているCPUの半分を占めており、Bedrockは10万社以上で利用され、AIエージェントを構築するためのAmazon Bedrock AgentCore SDKは数カ月で200万回以上のダウンロードが行われている。そして、既に38のリージョン、120のアベイラビリティゾーン、3.8GWsのデータセンター容量、光ファイバーケーブルは900万キロを超えているなど、AWSは世界最大かつ最も広く導入されているAIクラウドインフラストラクチャだ」と述べ、詰めかけた顧客に対し、その協力があればこそAWSはこうした実績を上げられたのだと、感謝の言葉から講演を始めた。

その上で、現在AWSが最優先事項としてAIに取り組んでいることに触れ、AWSは顧客に「発明の自由」を与えることを目指しており、AIでもそれは変わらないとし、「AIエージェントの登場でAIは大きな転換点を迎えている。これにより、技術の開発からエンドユーザーに価値を提供するものへと進化し、企業内でもっと大きな新しい使い方が実現されるだろう」と述べ、そうしたAIやAIエージェントなどを実現する要素として、5つ(冒頭の時点では4つだったが、講演の最後に1つ加わって5つになった)の要素を紹介した。

その5つが、GPUやASICなどのAI学習向けのインフラ、Bedrockなどに代表されるAI推論向けのマネージドサービス、データベース関連の新サービス、AIエージェント、フロンティアエージェントで、それぞれに新製品やサービスなどが発表されている。

なお、AI学習向けのインフラ、BedrockのAI推論向けのマネージドサービスなどに関しては、既に別記事で紹介しているので、そちらも合わせてご参照いただきたい。

生成AI学習向けのAIインフラを拡張、Amazon EC2 Trn3 UltraServersのラックを公開

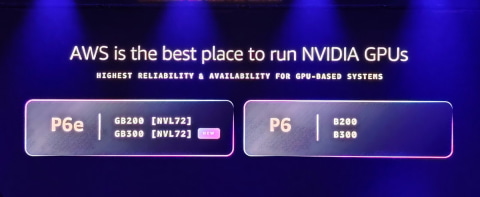

ガーマン氏はAI学習向けのインフラとしてNVIDIA GPUの新しいインスタンス(P6e GB300)とTrainium3のGA(一般提供開始)に関して説明した。

ガーマン氏は「多くの人はお忘れかもしれないが、クラウドサービス事業者でNVIDIA GPUをインスタンスとして提供したのはわれわれが最初だった。そこから15年にわたってNVIDIAと連携を進めており、今回は既に提供しているP6eの拡張としてP6e GB300の一般提供を開始する」と述べ、P6e GB300の一般提供開始を明らかにした。

これまでAWSは、P6e GB200というNVIDIAのGrace Blackwellを採用したインスタンスを提供してきたが、それが今回はGB300(Grace Blackwell Ultra)ベースに変更されている。GB300では、Blackwell Ultraの開発コードネームで知られる性能やメモリ容量が強化されたB300が2つ、ArmアーキテクチャのGrace CPUが1つの基板上に統合されているが、ラック上にB300が72基、Graceが36基搭載される形で実現されているのがGB300 NVL72となる。

また、オプションでそれをクラスター化したGB300 NVL72 UltraServersも提供される計画。AWSによれば、P6e-GB300はオレゴンリージョンで提供開始されており、GB300 NVL72 UltraServersはAWSの営業に要相談という形で提供される。

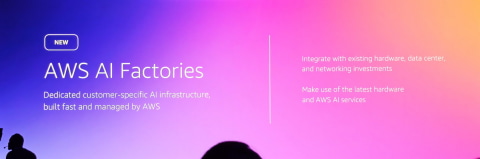

また、AIのデータセンターの構成要素をセットして提供する「AWS AI Foundries」では、NVIDIA GPUやAWS Trainium、さらにはAIを実現するAWSのソフトウェア群、Bedrockのマネージドサービスなどが包括的に提供される。

顧客のデータセンターなどにハードウェアやソフトウェアなどをセットで置く形での提供となり、つまり、従来Outpostとして提供されていたクラウドのハードウェア・ソフトウェアを顧客のデータセンターなどに置く形で提供される、AI版Outpostと考えるとわかりやすい。

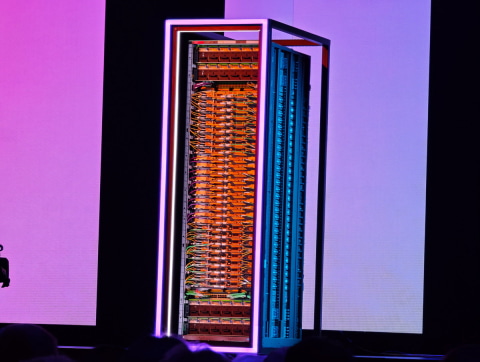

Trainium3に関しては、昨年のre:Invent 2024で技術概要が発表されたが、今回はGA(一般提供開始)となる。Trainium3は従来のTrainium2と比較して、プロセスノードが5nmから3nmへ微細化され、計算能力が2倍になり、エネルギー効率が40%改善されている。公開されたチップの写真を見る限り、1つのパッケージに2つのチップと複数のHBMメモリがチップレットの形で実装されており、Trainium2との類似性が高いと考えられる。

このTrainium3をクラスター化(AWSではUltraServersと呼ぶ)したのが、Amazon EC2 Trn3 UltraServersで、144基のTrainiumから構成されている。従来製品のAmazon EC2 Trn2 UltraServersと比較して4.4倍の演算性能、3.9倍のメモリ帯域幅、4倍のエネルギー効率を実現した。今回ガーマン氏は、講演の中でAmazon EC2 Trn3 UltraServersのラックを公開した。

また、Trainium4に関しても技術概要が発表されている。既報の通り、FP8で3倍、FP4で4倍、2倍のメモリ帯域が実現される。なお、今回はあくまで技術概要の発表になるので、昨年概要が発表されたTrainium3が今年GAになったように、Trainium4もGAとなるタイミングで、より詳細が明らかになる可能性が高い。

なお、ガーマン氏はTrainiumでの推論の可能性に関しても言及している。Trainiumはもともと学習に開発されたASICだが、実際のところは推論にも利用できる。ただ、負荷の低い推論に利用すると、電力効率などの観点でCPUなどと比べて不利になるため、より負荷が低い推論用の製品としてAWSはInferentiaという別の製品を提供してきた。

しかし、大規模なAI推論環境では学習と同じようにTrainium3のような大規模なASICやGPUでも実行するのがトレンドになっており、今回AWSは、Trainium3を利用したGPT-OSSの推論ワークロードで、従来製品と比較して3倍のスループット、4倍高速な応答時間を実現できると述べている。

Bedrock向けの新しい生成AIモデルの提供開始、Amazon Nova 2も提供開始

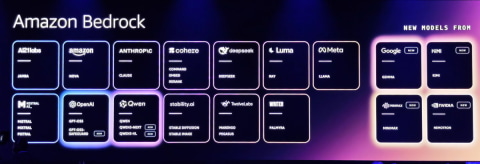

ガーマン氏はAWSのマネージドAI構築、実行環境となるBedrock用のAIモデルに関しても拡張を行うと説明した。

「われわれは以前よりAIモデルは顧客が選択すべきだと強調しており、今回もさらに新しい選択肢を提供していく」と述べ、Google Gemma 3やMistralなどの新しいAIモデルを追加したことを明らかにした。なお、今回追加されたAIモデルは以下の通りだ。

・Google;Gemma 3 (4B, 12B, 27B)

・MiniMax AI;MiniMax M2

・Mistral AI;Mistral Large3, Mistral 3(3B, 8B, 14B)、Mistral Small 1.2、Voxtral Mini 1.0、Voxtral Small 1.0

・Moonshot AI;Kimi K2 Thinking

・NVIDIA;Nemotron Nano 2 9B、Nemotron Nano VL 12B

・OpenAI;gpt-oss-safeguard-20b、gpt-oss-safeguard-120b

・Qwen;Qwen3-Next-80B-A3B、Qwen3-VL-235-A22B

また、ガーマン氏はAmazon/AWSが独自に開発したAIモデルである「Amazon Nova」の第2世代「Amazon Nova 2」を発表した。費用対効果重視のNova 2 Lite、高性能モデルのNova 2 Pro、会話AI向けのNova 2 Sonic、そしてマルチモーダルな入出力が可能で、複数のAIモデルを組み合わせなくてもテキスト、画像、音声、動画の入出力を実現するNova 2 Omniが追加された。

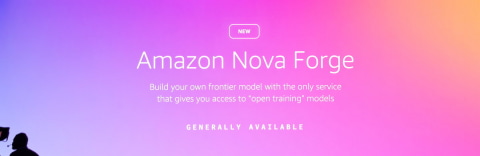

また、そうしたBedrock向けに、自社データでカスタマイズすることができるカスタマイズ可能なAIモデルとして「Amazon Nova Forge」が発表されている。通常、企業がそれぞれにカスタム化された生成AIを構築するには、自社でモデルを開発すると時間と費用が高くつく。そこで、途中まではAIモデル企業が学習しているデータを活用し、そこに自社データを読み込ませて自社向けにするカスタムAIモデルがトレンドになりつつある。Amazon Nova Forgeも、そうしたカスタム化が可能なカスタムAIモデルとなる。

BedrockのAIを利用してAIエージェントを作成・管理する「Amazon Bedrock AgentCore」には、2つの新機能、Policy in Amazon Bedrock AgentCoreとAmazon Bedrock AgentCore - Evaluationsが追加された。

前者はAIができないことを規定するガードレールに自社のポリシーを効率よく設定するツールで、後者はAIエージェントが期待通り動いているのかを継続的に評価するツールとなる。

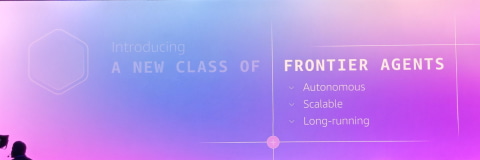

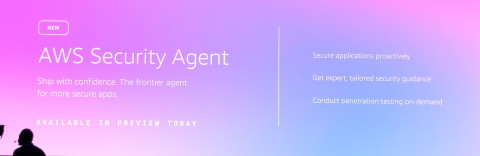

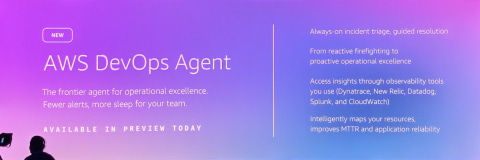

また、今回ガーマン氏は「フロンティアエージェント」と呼ばれるAIエージェントの進化版に関して説明した。ガーマン氏によれば「フロンティアエージェントは自律的に動作し、複数のタスクを同時に実行し作業を分散化できる伸縮性を持ち、人間の介入をあまり必要としないエージェント」という。一般的には「エージェンティックAI」として知られているAIエージェントの進化版だと考えられる。このフロンティアエージェント(エージェンティックAI)向けの新サービスとして、Kiro Autonomous Agent、AWS Security Agent、AWS DevOps Agentを発表した。

ソニーの小寺CDO、AdobeのナラヤンCEOが登壇し、AWSを利用したAIエージェントの構築などを説明

今回のガーマン氏の基調講演には3つの顧客企業が紹介されている。

それが日本のソニー、Creative CloudやExperience Cloudなどを提供しているAdobe、そして企業向けのAIエージェントを提供しているWRITERの3社だ。

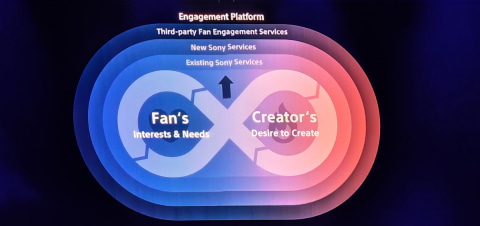

ソニーグループ株式会社 執行役 CDO(デジタル&テクノロジープラットフォーム(デジタルトランスフォーメーション戦略、情報システム、情報セキュリティ、先端技術領域)、R&D、技術戦略、品質マネジメント担当) 小寺剛氏は、ソニーがAWSのサービスを社内向けのAIエージェントやPlayStation5のファンエンゲージメントプログラムに使っている事例を紹介した。

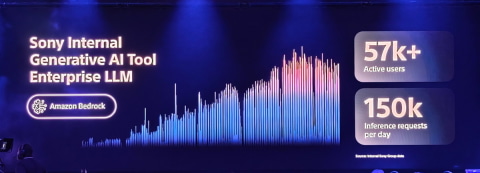

小寺氏によれば、ソニーはAmazon Bedrock AgentCoreを利用して社内に1日に15万件の推論リクエストを処理できるAIエージェントを構築しているという。これにより、従業員はコンテンツ作成、問い合わせ対応、予測、不正検知などに活用している。

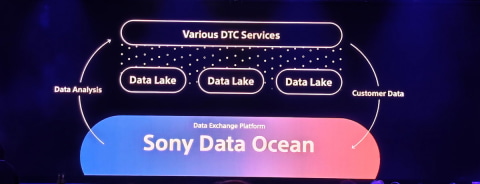

また、今回発表されたAmazon Nova Forgeを利用して、ソニーのデータで独自に学習した先進的なAIモデルを開発しており、それを活用することで社内プロセスの効率化を実現しているとも説明した。

さらにAWSのデータレイクとエンゲージメントプラットフォームを活用して、ファンとクリエイターのきずなを深める取り組みをしていると述べた。

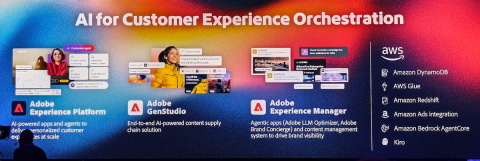

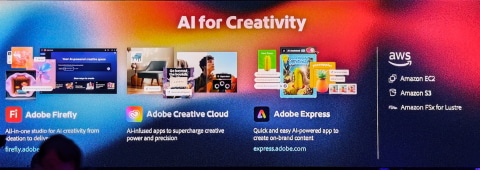

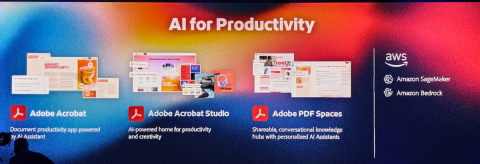

Adobe CEO シャンタヌ・ナラヤン氏は、Adobeの複数の製品に搭載されているAI/生成AI機能が、AWSのAI基盤を利用して実現されていることを説明した。

Adobeが10月末のAdobe MAXで発表したばかりの「Adobe Expressのエージェント機能」はAWSのAI基盤に基づいているほか、Acrobatの最新機能「Acrobat StudioのAIアシスタント機能」はAmazon Bedrockを利用して構築されており、さらにAdobeの生成AI機能や基盤として提供されているFireflyは、Amazon EC2のうちP5/P6インスタンス(NVIDIAのGPUのインスタンス)をベースに構築され、S3ストレージなども活用されているという。

ほかにも、企業向けのデジタルマーケティングツール「Adobe Experience Cloud」もAWSのサービスを活用して提供されていると説明した。

ナラヤン氏は「Adobeは早い段階から生成AIの機能をCreative Cloudに実装してきたが、そうした機能は多くがAWSの上で構築されている」と述べ、Adobeの生成AIやAIは、AWSとAdobeの協業の成果だと強調した。

ガーマンCEOは異例の「10分間25製品紹介チャレンジ」で基調講演の最後を締める

基調講演の最後に、ガーマン氏は「われわれの企業文化は“Why not”(日本語ではやってやれないことはない)だが、今回の講演の最後に、私は普通CEOならやらないことに挑戦したい。それが残りの10分で、25個の製品を紹介するというチャレンジだ」と述べ、会場を笑いに包むと、実際にその“無理ゲー”にチャレンジした。

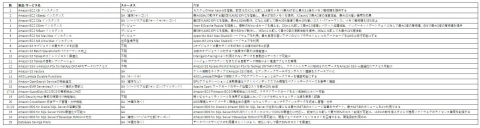

ガーマン氏がこの「10分間25個製品紹介」で紹介したのは、生成AIにはあまり関係ないようなCPUのEC2インスタンスやストレージサービスなどの製品。これらの製品は、AI向けというよりは、以前からAWSが提供してきた製品やサービスのアップデート版となる。

それなのに、トレンドの生成AI関連の製品やサービスよりも盛り上がった製品もあり、re:Inventというイベントが、実際にAWSを活用しているユーザーのためのイベントであることを感じさせられた瞬間だった。

なお、そうした製品やサービスに関しては、以下の表で紹介していきたい。

なお、ガーマン氏は、10分間をほぼフルに使い切って、もうすぐ終了の音楽が鳴り響く中で紹介を終了させ、今回の基調講演をきっちりと締めて終えた。