イベント

AWS、Trainium3のGAとTrainium4の概要を発表 新自社AIモデル「Nova 2」も投入

ソニーはBedrock AgentCoreを利用し、社内・社外向けのAIエージェントを構築

2025年12月3日 06:00

米Amazon Web Services(AWS)は12月1日~5日に、米国ネバダ州ラスベガス市の会場において、同社の年次イベント「re:Invent 2025」を開催している。例年、re:InventはAWSの新製品や新ソリューションなどが発表されるイベントになっており、今年も生成AIの学習向けインフラ、推論向けのマネージドサービス、データ管理、AIエージェント、開発ツールなどに関して、多くの新サービスが発表される予定だ。

12月2日の午前8時(現地時間、日本時間では12月3日午前1時)からは、同社 CEO マット・ガーマン(Matt Garman)氏による基調講演が行われる予定になっているが、AWSはそれに先だって報道発表を行い、同社がre:Invent 2025で発表を予定している新サービス・製品の概要を明らかにした。

昨年発表されたAI用のASIC「Trainium3」の一般提供開始(GA)と、その次世代となる「Trainium4」の概要が明らかにされたほか、昨年の同イベントで発表されたAmazon/AWS独自のAIモデル「Amazon Nova」の第2世代となる「Amazon Nova 2」などが発表された。

昨年実績で約6万人という参加者を集めて開催される巨大イベント「re:Invent」

AWS re:Inventは、例年11月下旬から12月上旬に開催されており、本年も12月1日~12月5日に、ラスベガス市内の複数の会場で開催されている。その中でもメインの会場となるのは「The Venetian Expo」と呼ばれる、The Venetianホテルの展示会用の展示ホールだ。基調講演などのメインの講演はThe Venetian Expoで行われ、市内のサブ会場では、そこには入りきらない各種の分科会や展示などが行われる形になっている。

12月1日からはすでに展示会や一部の分科会などが始まっており、いずれも多くの参加者が集まっている。昨年の例でいうと、リアルでは6万人という参加者を集めており、一私企業のテック系イベントとしては最大級の規模と言ってよいだろう。また、日本にはAWSのユーザー企業が多いという事情を反映して、日本からの参加者も多く、あくまで筆者の肌感覚にすぎないが、ほかのテック系のイベントよりも日本人参加者との遭遇率は高いと感じる。

そうしたre:Inventでは、例年、会期初日(今年でいうと12月1日)に「Monday Night Live」(月曜夜ライブ)と名付けられたインフラ関連の講演がキックオフとして行われていたのだが、今年はそれが4日目(12月4日)午前へと移動になり、通常は4日目午前に行われていたAmazon CTOのワーナー・ボーグルス氏の基調講演が4日目午後に移動になるなど、スケジュールに若干の変動が出ている。

しかし、例年通り2日目(12月2日)にAWS CEO マット・ガーマン氏による講演が行われ、そこで多くの新サービスなどが発表されることになる。

NVIDIAのGB300 NVL72を採用したP6eインスタンスやTrainium3の一般提供開始を発表

AWSは、生成AIのインフラ(具体的にはGPUやASICなどのハードウェア)の強化を発表した。AWSはすでに、P6というNVIDIAのBlackwellを搭載したEC2インスタンスを発表しており、NVIDIAのGB200 NVL72(36基のGrace CPUと72基のB200 GPU)を搭載したラック単位のP6e-GB200、およびNVIDIA GPU単体のインスタンスとなるB200、B300それぞれのP6の一般提供が開始されている。

今回のre:Invent 2025では、P6eのGB300版となるP6e-GB300の一般提供開始が発表された。P6e-GB300は、GB300 NVL72というラック1つで36基のGrace CPU(Arm ISA)と72基のGB300(Blackwell GPU)を利用でき、AIの学習用として使うことが可能だ。

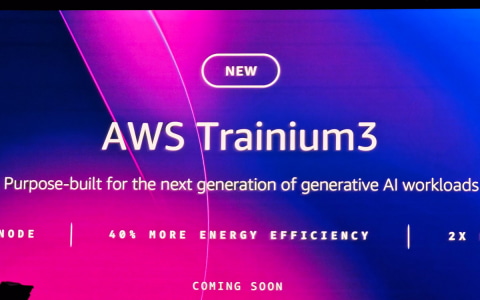

また、昨年のre:Invent 2024では、同社の学習/推論用のASIC「Trainium3」の技術概要を発表したが、今回のre:Invent 2025ではその一般提供開始が発表された。

AWSは、Trainium3を144基搭載した「Trainium3 UltraServers」と呼ばれるシステム(ラック)を構築しており、Trainium2 UltraServersと比較して計算性能が4.4倍(Trainium3 UltraServersは362PFLOPS、Trainium2 UltraServersは83.2PFLOPS)、エネルギー効率が4倍、メモリ帯域幅がほぼ4倍になっており、従来世代と比べて、より高い費用対効果を実現する。

なおTrainium3 UltraServersでは、スケールアップ時のインターコネクトに新しいNeuron Fabricネットワーキングを利用し、NeuronSwitch-v1という新しいスイッチチップにより、10マイクロ秒以下の低遅延でチップ間通信が可能になっている。

NVLink Fusionに対応した次世代Trainium4の技術概要や、NVIDIAと協力したAWS AI Factories構想を発表

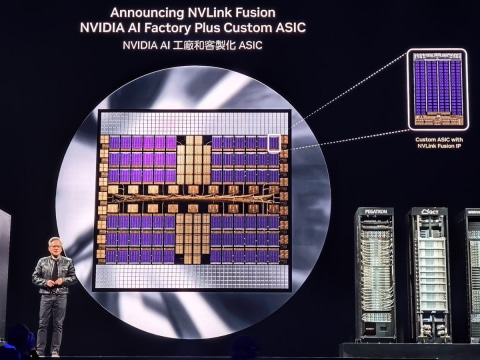

AWSはTrainium3の次世代製品となる「Trainium4」の技術概要も発表した。Trainium4では、Trainium3と比較してFP4の性能が6倍に、FP8の性能は3倍、メモリ帯域は4倍となり、いずれも推論で利用される精度(FP4/FP8)での性能が強化される。

これにより、学習だけでなく大規模な推論でも、より活用しやすくなる。また、NVIDIAのNVLink Fusion(NVIDIAのCPU、GPUで採用されているインターコネクト)にも対応する予定で、NVIDIAのGPUとTrainium4を1つのラックに入れて利用することができる。

こうした両社の提携は、AIデータセンターレベルでも行われる。今回AWSは「AWS AI Factories」と呼ばれるAIデータセンター構想を明らかにしたが、NVIDIAの現行製品「Grace Blackwell」、次世代製品「Vera Rubin」、NVIDIA NVLink Fusionに対応したTrainium4などから構成されることになる。

さらに、サウジアラビアのAI企業であるHUMAINと協業し、同社がサウジアラビアに建設中のAIデータセンターに、AWSが「AI Zone」を設ける。このAI Zoneには、NVIDIA GPUを含むAIチップが15万基統合され、AWSが運営やソフトウェアスタックなどを提供する形になる。

HUMAIN CEO アレック・タミン氏は、AWSが発行したプレスリリースの中で「AWSが私たちの新しいAIゾーンに構築しているAIファクトリーは、HUMAINとAWSにとって数ギガワット規模の旅の始まりを意味します。このインフラは、地元および世界的なAIコンピュート需要の加速に対応するために設計されています」と述べ、今後AI Zoneがさらに拡張される可能性を示唆している。

自社AIモデル「Amazon Nova」の第2世代「Amazon Nova 2」を発表

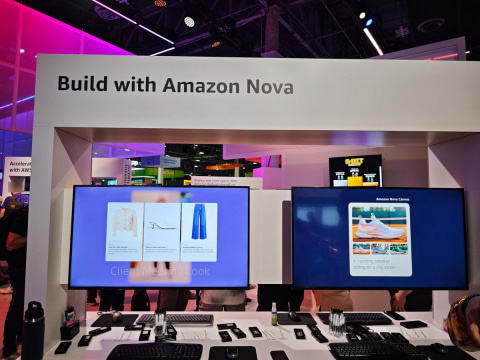

AWSは、昨年のre:Invent 2024で発表した同社独自のAIモデル「Amazon Nova」の第2世代となる「Amazon Nova 2」を発表した。

Amazon Novaは、同社のマネージドAI推論環境「Amazon Bedrock」向けに提供されている独自のAIモデル。今回AWSは、Nova 2ファミリーのAIモデルとして、費用対効果に優れたNova 2 Lite、性能重視のNova 2 Pro、スピーチ向けに特化したNova 2 Sonicを追加したほか、リーズニングやマルチモーダルな処理が可能になるNova 2 Omniを発表した。

さらに、Mistral AIのMistral Large 3およびMistral 3、GoogleのGemma 3、MiniMaxのM2、NVIDIAのNemotron、OpenAIのGPT OSS Safeguardなども、BedrockのAIモデルとして今後選択可能になる。

AIエージェント関連では、6月に発表したAIエージェント構築ツール「Amazon Bedrock AgentCore」に、新機能としてAIエージェントに適用するポリシーをユーザー企業が自分で作成できる「Policy In AgentCore」や、AIエージェントの動作確認をこれまでよりも簡単にできるようになる「AgentCore Evaluations」が追加された。

またAWSは、3つの新しいフロンティアエージェントを発表した。「Kiro autonomous agent」は仮想開発者として機能し、コンテキストを維持しながら独立して作業を行い、時間とともに学習する。

「AWS Security Agent」は、仮想セキュリティエンジニアとして、アプリケーション設計、コードレビュー、動作検証などを通じて安全なアプリケーション構築を支援する。「AWS DevOps Agent」は、仮想運用チームメンバーとして、インシデントの解決や予防を支援し、アプリケーションの信頼性とパフォーマンスを継続的に向上させる。

これらの新しいAIエージェントにより、企業が業務効率を改善するAIエージェントの構築を容易にし、大企業の生産性向上に大きく寄与すると、AWSは説明している。

ソニー、Bedrock AgentCoreを利用して、社内、社外向けのAIエージェントを構築

ソニーは、AWSのAIエージェント環境「Amazon Bedrock AgentCore」を活用して、社内・社外向けのエンタープライズグレードAIエージェント基盤を構築することを明らかにした。

Amazon Bedrock AgentCoreは、A2A/MCPなどのオープンプロトコルを活用しながら、AIエージェントを構築・運用することができるマネージドサービス。これを利用することで、エンタープライズ企業はガードレールなどのセキュリティ性を確保しながら、AIエージェントの機能を社内外に提供可能になる。

ソニーはこのAIエージェント基盤を、社内向けにAIエージェントを提供する用途で活用する計画で、1日あたり15万件の推論リクエストを処理し、社員のコンテンツ作成、問い合わせ対応、予測、不正検出、ブレインストーミング、新しいアイデアの起案などを支援するという。

この業務効率の改善には、Amazon Nova Forgeプログラムが活用される。AIエージェントの性能が強化され、社内のドキュメント評価・審査プロセスの効率が従来比で約100倍に向上する可能性が示されたことを明らかにしている。

さらに、AWSの各種サービスを利用して、ファンとクリエイターのつながりを強化するエンゲージメント基盤を構築する。ソニーのデータ利活用基盤となる「Sony Data Ocean」が、Amazon SageMakerを含むAWSの各種サービスで構築され、AWS上に構築されたソニーのエンゲージメントプラットフォームにより、ソニーの子会社であるPlayStationを提供しているソニー・インタラクティブエンタテインメント(SIE)が、PlayStationオンラインサービスのコア機能として活用していく。それにより、PlayStationオンラインサービスのアカウント、決済、データ基盤、セキュリティなどのコア機能が拡張され、ファンとゲームクリエイターがより深いつながりを実現可能になることが明らかにされた。