ニュース

レッドハット、「Red Hat AI 3」でエージェント開発機能の拡充と推論機能のさらなる進化などを実現

2025年12月4日 06:15

レッドハット株式会社は、企業向けAIプラットフォーム製品「Red Hat AI」の最新版「Red Hat AI 3」を発表した。米国で10月に発表された内容が、今回日本で発表された。

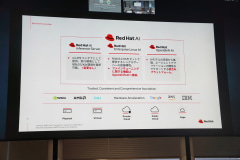

Red Hat AIは、「Red Hat AI Inference Server」「Red Hat Enterprise Linux AI(RHEL AI)」「Red Hat OpenShift AI」の3製品を合わせたブランドだ。Red HatはRed Hat AI 3により、組織のAI投資をPoCから本番環境へと移行させるとうたっている。

同日、レッドハットのパートナー企業にRed Hat AI 3を紹介するイベント「Red Hat AI 3 Launch Party」が開催され、その新機能が説明された。

Red Hat AI 3の機能強化点

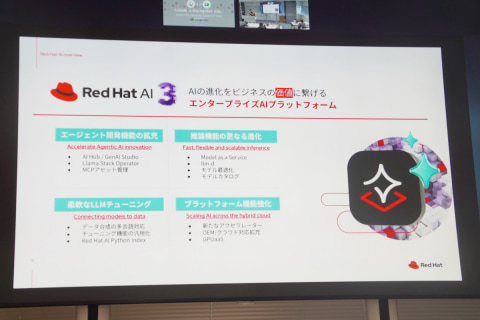

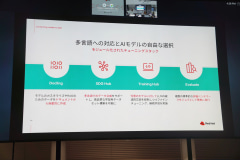

レッドハット株式会社の石川純平氏(AIシニアスペシャリスト ソリューションアーキテクト)は、Red Hat AI 3の機能強化点について、「エージェント開発機能の拡充」「推論機能のさらなる進化」「柔軟なLLMチューニング」「プラットフォーム機能強化」の4分野に分けて説明した。

まず前述のとおり、Red Hat AI 3は、推論エンジンの「Red Hat AI Inference Server」、OSの「RHEL AI」、OpenShiftをベースにしたAIプラットフォーム「Red Hat OpenShift AI」の3製品から構成されている。それぞれのバージョンは、Red Hat AI Inference Serverが3.2、RHEL AIが3.0、Red Hat OpenShift AIが3.0だ。

この3製品の構成は、前バージョンの「Red Hat AI 2」から変わらない。

一方で変わった点として、シングルサーバーでのファインチューニング機能がRHEL AIに含まれていたのに対し、Red Hat AI 3ではファインチューニング機能をOpenShift AIにまとめたことを石川氏は紹介した。

開発機能の強化:Model Catalogや、MCPサーバーの一元管理、Playgroundなど

1つめの分野は「エージェント開発機能の拡充」だ。

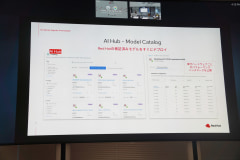

AIリソースを管理する「AI Hub」の「Model Catalog」は、Red Hatによる検証済みAIモデルのカタログで、ここからすぐにデプロイできる。カタログ内のモデルの説明には、GPUなどのハードウェアごとのパフォーマンスのベンチマーク結果も表示される。

「GenAI Studio」は、AIアプリケーションのプロトタイプを作成するためのワークベンチだ。

その中の「AI asset endpoints」は、企業内で使うモデルやMCPサーバーをリストに登録して一元管理する機能で、これにより、これらのサーバーなどをある程度統制のとれたものにできる。

また「Community MCP server Catalog」は、MCPサーバーのコンテナイメージをRed Hatがビルドして提供するものだ。これをアセットとして、AI asset endpointsに登録できる。

そして「GenAI Studio」の「Playground」は、デプロイしたモデルやMCPをすぐに試せる実験場。AI asset endpointsからPlaygroundにMCPサーバーを追加すると、Playgroundですぐ試すことができる。

実演デモでは、「Weather-MCP-Server」を選んで対話形式で天気を尋ねるところや、「Kubernetes-MCP-Server」を選んで稼働中のKubernetesの情報を尋ねて取得する様子や、取得した情報を「Slack-MCP-Server」を選んでSlackに投稿する様子がデモされた。

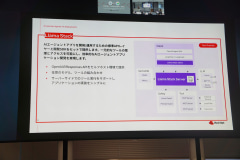

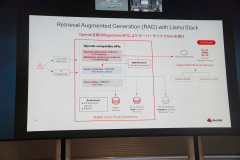

「Llama Stack」は、AIエージェントアプリを開発・運用するための標準APIレイヤと開発SDKをセットで提供する(Tech Preview)。OpenAIのResponses APIに基づいたAPIをセルフホスト環境で実現する。なお、MetaとRed Hatがオープンソースとして開発している。

推論機能の強化:分散推論を助けるllm-dなど

2つめの分野は「推論(inference)機能のさらなる進化」だ。ここでは、推論サービスへのアクセスを管理する機能や、推論を効果的にスケールさせる機能が追加された。

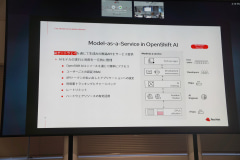

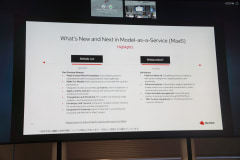

まず、アクセスを管理するAI Gatewayが「Model-as-a-Service(MaaS)」だ。企業におけるAIモデルの実行と利用を一元管理することで、リソースのムダを防いだり、簡単にアクセスできるようにしたり、ユーザーごとに認証したり、利用量トラッキングをしたりできる。現在はDeveloper Previewで、2026年にGA(一般提供開始)予定。

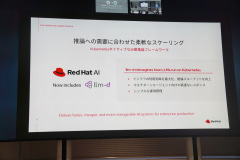

分散推論では、vLLMを基にした「llm-d」がGAとなった。複数のノードで推論させるときに、リニアにパフォーマンスをスケールできるようにするフレームワークと石川氏は説明した。これにより、効率やスループット、高速なレスポンスなどを実現する。

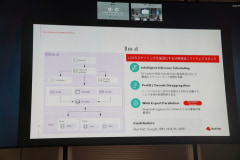

背景として、通常のコンテナアプリケーションと比べたLLM推論のスケーリングの事情があると石川氏は言う。LLM推論では、複数のPodに分散した場合にKVキャッシュがどのPodにあるかで推論のパフォーマンスが大きく変わることや、GPUを効率的に使う必要があることなど、スケールするときに考慮すべき点がある。

そこでllm-dでは、こうした問題に対応し、スケールしたときにトークンの効率を最大化する。そのための技術として、推論のリクエストを適切なインスタンスにルーティングする「Intelligent Inference Scheduling」や、KVキャッシュの計算とトークンのアウトプットを別のGPUに割り当てる「Prefill / Decode Disaggregation(Prefill / Decode Disaggregation(PrefillとDecodeの分離))」などを石川氏は解説した。

そのほか、llm-dを画面からデプロイできるようになったことも紹介された。ただし、まだ単純な設定のみで、細かい設定はYAMLで行う。

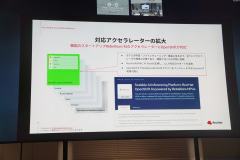

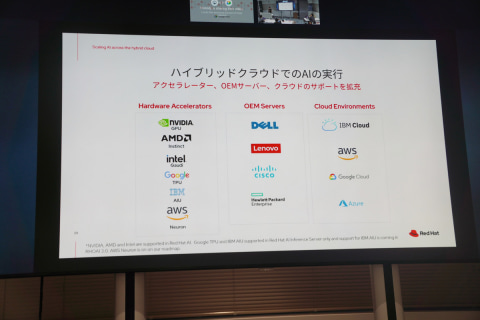

Red Hat AI Inference Serverでは、さまざまなクラウドやアクセラレーター(GPUなど)をサポートしている。

その中で対応アクセラレーターの拡大として、韓国Rebellion社のアクセラレーターに新しく対応した。

「LLM Composer」は、AIモデルの量子化(パラメータのビット数を減らすこと)を行うツールだ。できるだけ性能を保つようにしつつ、モデルのサイズを削減する。

LLMチューニングの強化:InstructLabがモジュールに分割、日本語のファインチューニングにも対応

3つめの分野は「柔軟なLLMチューニング」だ。

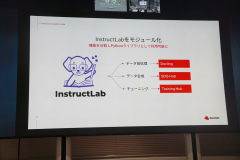

基盤LLMモデルを独自データでファインチューニングするツールとして、以前から「InstructLab」が用意されている。今回は、このInstructLabがモジュールに分割されて、Pythonライブラリとして個別利用できるようになった。

また、日本IBM 東京基礎研究所とのコラボレーションにより、日本語での合成データ作成とファインチューニングが可能になったのも特徴だ。これについては日本IBMのセッションで後述する。

そのほか、ファインチューニングしたときに元のモデルの知識の一部が失われる「破滅的忘却」への対応が拡大された。これまではIBMのGraniteモデルに限られていたが、手法を変えて任意のモデルに対応できるようになった。

プラットフォームの強化:対応アクセラレーターの拡充や、GPUを動的に分割する機能など

4つめの分野は「プラットフォーム機能強化」だ。

Red Hat AIは、Red Hat AIは、さまざまなクラウドやアクセラレーターに対応することを特徴としている。この対応がさらに拡充された。

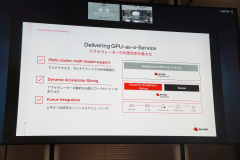

「GPU-as-a-Service」として、アクセラレーターを効率的に使う仕組みが導入されている。まずマルチクラスタとマルチテナントでの利用を最適化する。

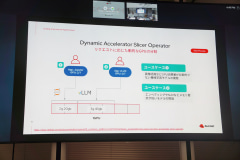

また、リクエストに応じてGPUを動的に分割する「Dynamic Accelerator Slicing」が提供開始された(Tech Preview)。これは、1つのGPUを占有するほどではないジョブについて、GPUを分割して割り当てるものだ。これまでプリコンフィグが必要だったものが、動的に分割できるようになった。

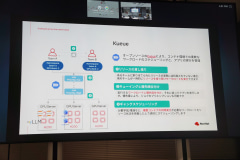

そのほか、「Kueue」により、GPUリソースを柔軟に割り当ててスケジューリングできる。リソースの貸し借りや、キューイングと優先順位づけ、複数コンテナの同時実行のギャングスケジューリングなどに対応する。このKueueは以前からあったが、コンソール画面にインテグレーションされるようになった。

そのほか、新しい製品SKU「Red Hat AI Enterprise」が追加される。これまで、Red Hat OpenShift、Red Hat OpenShift AI、Red Hat AI Acceleratorの3つを個別に購入する必要があったものが、セットで購入できるようになった。CPUコアやソケット単位ではなく、物理もしくは仮想マシンの台数単位で課金される。

石川氏は最後に、今回のRed Hat AI 3では企業のビジネスに使っていく機能を強化していると意義をまとめ、「今後も機能をアップデートしていく」と語った。

InstructLabのモジュール分割と日本語ファインチューニング対応を日本IBM 東京基礎研究所が解説

石川氏の話の中にもあった、InstructLabのモジュール分割と、日本語ファインチューニング対応については、日本IBM株式会社 東京基礎研究所の竹内幹雄氏(シニアリサーチサイエンティスト AIモデルズ 部長)が説明した。

前述したように、InstructLabは、Red Hat AI 3ではモジュールの集まりであるツールキットになった。主なモジュールとしては、合成データ生成フレームワークの「SDG Hub」や、LLMトレーニングフレームワークの「Training Hub」がある。

このうち、SDG Hubにおいて日本語文書に対応するためのローカライゼーションを実施したことを竹内氏は紹介した。

ローカライゼーションの方針は、既存のものを構造を変えずにそのまま利用すること。そこで、英語用のパイプライン定義をコピーし、文を出力するときに日本語で出力する指示をプロンプトに追加したとのことだ。

もう一方のTraining Hubは、訓練ライブラリへのインターフェイスであり、これ自身は訓練を行わない。なお、こちらは日本語対応のローカライゼーションは必要ない。

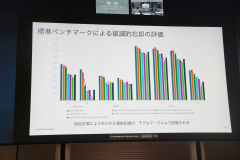

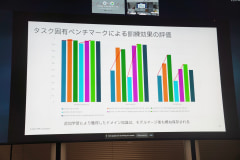

竹内氏は、インターネットで公開されている官公庁の文書を元に、SDG Hubで合成データを生成し、Training Hubでファインチューニングを実行した結果を紹介した。破滅的忘却を防ぎつつ、追加した分野の質問で知識が増えているという結果になったと同氏は報告した。