ニュース

Project Bobで生産性45%向上、watsonx Orchestrateは5倍高速化――日本IBMがTechXchange 2025の発表を解説

2025年11月27日 06:30

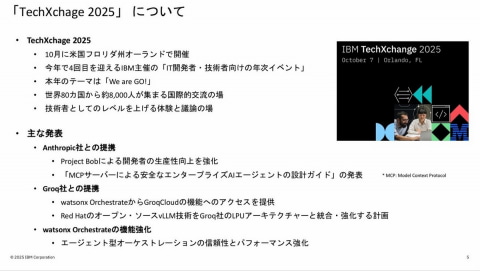

日本アイ・ビー・エム株式会社(以下、日本IBM)は25日、10月に米IBMが米国フロリダ州にて開催した年次イベント「IBM TechXchange 2025」での発表内容について説明会を実施した。IBM TechXchange 2025は、IT開発者および技術者向けの年次イベントで、今回が4回目の開催となる。

日本IBM テクノロジー事業本部 ソフトウェア・テクニカルセールス事業部 技術理事の菱沼章太朗氏は、今年の同イベントのハイライトとして、AnthropicやGroqとの提携、そして「watsonx Orchestrate」の機能強化を挙げた。

「Anthropicとの提携により、『Project Bob』で開発者の生産性向上を強化したほか、Anthropicが検証した『MCPサーバーによる安全なエンタープライズAIエージェントの設計ガイド』を作成した。また、Groqとの提携では、『watsonx Orchestrate』から『GroqCloud』の機能にアクセスできるようにしたほか、Red HatのオープンソースvLLM技術を、GroqのLPUアーキテクチャと統合し強化する。そしてwatsonx Orchestrateそのものの機能としては、エージェント型オーケストレーションの信頼性とパフォーマンスを強化した」(菱沼氏)。

開発支援ツールProject Bob

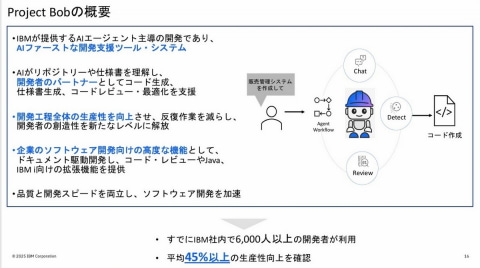

Project Bobとは、IBMが提供するAIエージェント主導の開発支援ツールシステムのことだ。AIがリポジトリーや仕様書を理解し、開発者のパートナーとしてコードの生成や仕様書の生成、コードレビュー、そして最適化を支援する。また、企業のソフトウェア開発向けの高度な機能として、ドキュメント駆動開発やコードレビュー、JavaおよびIBM i向けの拡張機能を提供している。

日本IBM テクノロジー事業本部 watsonx事業部 テクニカル・スペシャリストの張重陽氏は、「Project Bobにより、ソフトウェア開発の品質と開発スピードが両立できる。開発者は反復作業が減り、本質的な創造性を発揮する作業に集中できるようになる」と、その利点を強調。実績として、「すでにIBM社内で6000人以上の開発者が利用しており、平均45%以上の生産性向上を確認している」(張氏)と話す。

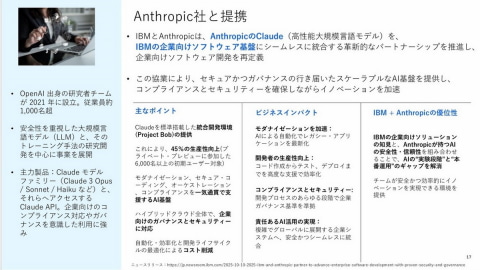

Anthropicとの提携により、同社のLLM「Claude」をProject Bobに標準搭載して提供できるようになった。「AnthropicのLLMとIBMの企業向けソフトウェア開発基盤をシームレス統合することによって、企業のソフトウェア開発の複雑なニーズに応えることができる」と張氏は述べている。

張氏は、企業の情報収集ウェブアプリを題材にしたProject Bobのデモを披露、要件整理からドキュメント生成、実装、レビューまでの一連の流れを紹介した。

デモでは、Bobがエンジニアのあいまいな指示を質問で整理し、API設計書やアーキテクチャ設計書などのドキュメントを自動で作成。その後、PythonとFlaskを用いてアプリのコードを生成した。レビュー段階では、セキュリティやパフォーマンスの問題を「BOB FINDINGS」というダッシュボードで可視化し、AIによる自動修正で最適化した。

watsonx Orchestrateの機能強化

もうひとつの発表であるwatsonx Orchestrateについては、日本IBM テクノロジー事業本部 watsonx事業部 テクニカル・スペシャリストの長田栞氏が説明、「企業からの問い合わせ対応や営業支援などで活用が進み、パイロット導入も拡大しているが、本格的に業務統合してROIを得ている企業は世界で約5%にとどまっているとの調査もある。性能やユーザー体験、管理面が課題の一部として指摘されており、今回こうした課題を解決するアップデートを施した」としている。

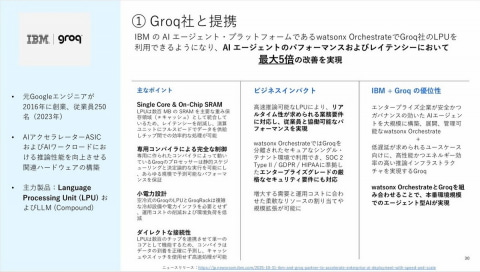

その中でも特に注目されるのは、Groqと提携し、watsonx OrchestrateでGroqのLLM特化型LPU(Language Processing Unit)を利用できるようになったことだ。従来のLLM処理に用いられていたGPUサーバーとは異なり、LPUは生成AI向けに特化して設計されたコンパイラやチップ接続技術を採用していることから、「watsonx OrchestrateでLLMの推論処理を最大5倍高速化することに成功した」(長田氏)という。

これは、「特に複数のAIエージェントが連携して動作するマルチエージェント環境において効果が大きい」と長田氏。同氏は、同じモデルを使用したGPU環境とLPU環境でのデモを実施し、質問への応答やプレスリリースのドラフト作成においてLPUがGPUより高速に処理を完了する様子を披露した。

watsonx Orchestrateでは、ガバナンス機能も強化された。IBMのAIガバナンス製品「watsonx.governance」の一部機能をwatsonx Orchestrateに統合し、AIエージェントの本番導入前の評価や稼働後の継続的なモニタリングが可能になった。

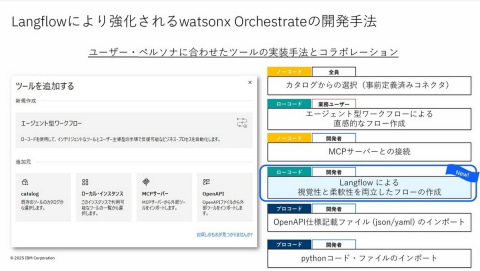

また、DataStaxが開発したオープンソースの生成AIワークフローツール「Langflow」とwatsonx Orchestrateの統合も発表した。この統合により、従来の業務ユーザー向けのノーコード・ローコード機能に加え、開発者向けにも柔軟なローコード開発環境が提供できるようになった。長田氏は、「幅広い開発者のニーズに対応し、マルチエージェントのオーケストレーションをより効率的に実現できるようになる」と述べている。