ニュース

NTTドコモビジネス、分散データセンターの実現に向け800G-ZRによる長距離接続とRDMA技術を活用したデータの高速転送を実現

2025年9月2日 06:30

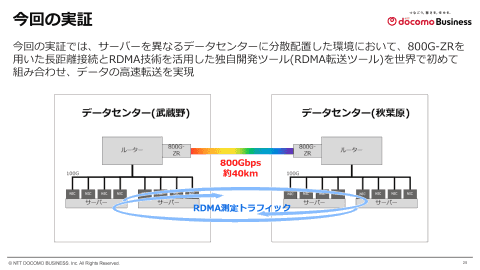

NTTドコモビジネス株式会社(旧:NTTコミュニケーションズ)は8月27日、サーバーを異なるデータセンターに分散配置した環境において、800G-ZRによる長距離接続とRDMA技術を活用した独自開発ツール(以下、RDMA転送ツール)を世界で初めて組み合わせ、データの高速転送を実現したと発表した。

今回実証した技術を用いることで、分散されたデータセンターにおけるネットワーク構成が簡素化され、消費電力や運用コストを削減しながら高速なデータの転送が可能になると説明する。この成果により、離れたデータセンターを一つのデータセンターのように利用できるようになり、データセンターの柔軟な利用を実現するとしている。

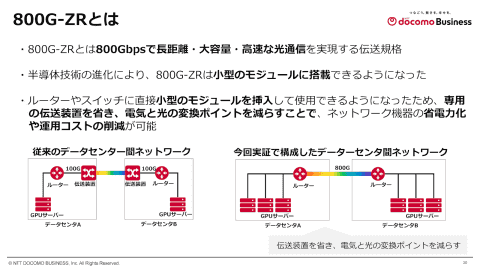

800G-ZRは、急増するデータセンター間の通信量への対応において、800Gbpsの大容量かつ高速な伝送が可能な点に加え、効率的なネットワークの接続技術として注目されている。サーバーインターフェイスが100Gや400Gへと進化する中、800G-ZRはこれらの集約トラフィックを低遅延で長距離伝送できる。また、小型なモジュールで実現できており、ルーターやスイッチに直接モジュールを挿入して使用できるため、ネットワーク構成の簡素化、消費電力や運用コストの削減にも貢献する。

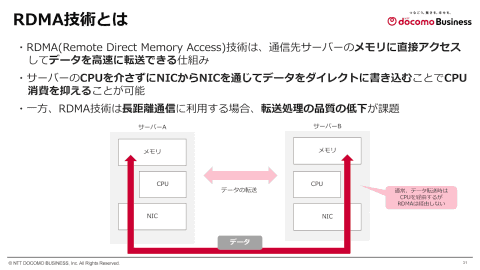

RDMA(Remote Direct Memory Access)は、通信先のサーバーのメモリに直接アクセスしてデータを転送できる仕組み。CPUを介さずにNICからデータを直接書き込むことで、高速なデータ転送が行える。一方、RDMAは長距離通信での利用において転送処理の品質に課題があったが、独自に開発したRDMA転送ツールでは、CPUのリソース消費を抑えながら長距離通信においても高速なデータ転送を実現する。

実証では、世界で初めてIOWN APNの技術要素の一つである800G-ZRと独自開発したRDMA転送ツールを組み合わせることで、データセンター間の複数サーバーにおいて、800Gbps級の広帯域の接続かつ高速なデータ転送の実現に成功した。従来技術と比較して、1600GBのデータ転送所用時間は約389秒から約68秒となり、最大で6分の1まで短縮された。また、CPU使用率も約20%から約5%に低下し、最大5分の1の使用率まで削減できることを確認した。

これにより、AI時代に求められる高速・低負荷なデータ処理基盤の構築に向けた大きな前進となったと説明。また、800Gbpsによるデータセンター間接続を実現したことで、データセンターの処理における効率性がさらに向上し、柔軟なリソース活用と拠点間連携の強化に貢献するとしている。

距離3000kmの2拠点模擬環境で単一データセンターとほぼ同等の性能を確認

IOWNのコンピューティング領域の技術評価・検証を手がけるNTTドコモビジネス エバンジェリストの張暁晶氏は、昨今のデータセンターのトレンドとしてAI向けの需要が増えていることを紹介し、「数年前のGPT-3でも、NVIDIA H100を512枚使うことが標準とされている。一方、一般的なサーバーではGPUの搭載枚数は1台につき8枚程度で、複数台のGPUサーバーを並べて使うシーンが増えている」と語った。

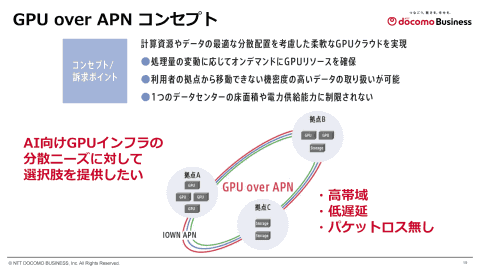

AI向けGPUインフラに必要な特徴としては、高い計算能力と並列処理性能、大量の電力消費と発熱、高速インターコネクトと大容量ストレージ、柔軟なスケーラビリティと運用管理を挙げた。こうした課題から、ラックあたりの電力密度、冷却能力、床荷重制限などの制約により、「やむをえず」データセンターを分散する動きがある一方で、事業継続・災害復旧の観点からは、「あえて」データセンターを分散する動きもあるとした。

また、AIインフラに関する総務省の見解でも、ワット・ビット連携の実現に向けてデータセンターの分散化が挙げられており、NTTドコモビジネスでも2025年6月に「AI-Centric ICTプラットフォーム」を発表し、IOWN APNを活用したデータセンター分散への取り組みを進めているとした。

NTTドコモビジネス イノベーションセンター IOWN推進室 担当課長の野山瑛哲氏は、分散されたデータセンターにおいてIOWNを活用する「GPU over APN」のアップデートについて説明した。

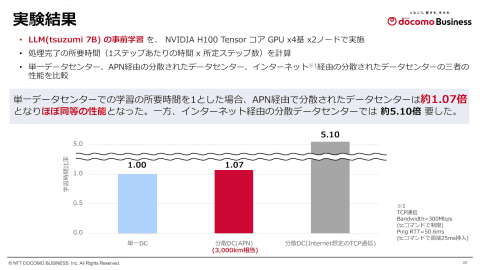

NTTドコモビジネスでは、IOWN APNを活用した分散データセンターの実現に向け、2024年10月には分散データセンターでの生成AI学習実証実験に世界で初めて成功、2025年3月にはGPUの3拠点分散データセンター構築に成功しているが、今回の実験では3000kmの超遠距離を模擬した2拠点間で、AIモデル学習の所要時間を測定した。

実験では、LLM(tsuzumi 7B)の事前学習を、NVIDIA H100 Tensorコア GPU×4基×2ノードで実施。単一データセンターでの学習の所要時間と比較して、APN経由で分散されたデータセンターの所要時間は約1.07倍と、ほぼ同等の性能となった。一方、インターネット経由の分散データセンターでは約5.10倍となり、APN経由での分散データセンターの有効性が確認できたという。

NTTドコモビジネス イノベーションセンター IOWN推進室 担当課長の木村安宏氏は、実証で用いた800G-ZRとRDMA転送ツールについて説明した。

データセンター間のネットワークでは、2021年頃に400Gbpsが普及しはじめたが、生成AIなどに必要となる大容量・高速な通信のニーズがネットワーク装置の進化を牽引し、現在では800Gbpsが注目されるようになっていると説明。800G-ZRは、800Gbpsで長距離・大容量・高速な光通信を実現する伝送規格で、過去の製品に比べて小型なモジュールで実現でき、ルーターやスイッチに直接モジュールを挿入して使用できるようになった点が特徴だとした。

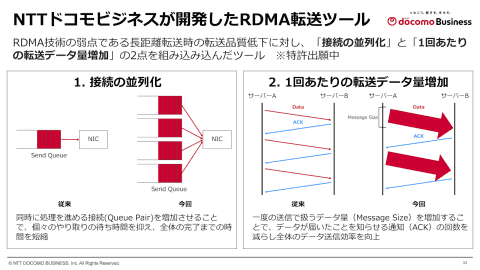

また、RDMA技術は、通信先サーバーのメモリに直接アクセスしてデータを高速に転送できる仕組みで、CPUを介さずにダイレクトにメモリにアクセスすることで、高速通信を実現する。NTTドコモビジネスでは、RDMA技術の弱点である長距離転送時の品質低下に対し、「接続の並列化」と「1回あたりの転送データ量増加」の2点を組み込んだツールを開発した。

実験では、RDMA転送ツールを用いた場合、転送時間は最大で約6分の1に短縮でき、トラフィック量は約8倍の帯域性能を実現した。また、CPU使用率は最大5分の1となり、800G-ZRとRDMA転送ツールのそれぞれの特長を生かすことで、分散されたデータセンターにおいて、GPUクラスタ環境の効率性向上、ネットワーク運用の簡素化、柔軟なリソース活用などにおいて、有用であることが確認できたとした。

NTTドコモビジネスでは、今回の実証の成果をもとに、IOWN APNで接続されたデータセンターにおけるGPUクラスタの可能性をさらに広げていくと説明。2026年度には、GPU over APNの検証環境を顧客に提供開始する予定としている。