ニュース

ソフトバンク、AIデータセンターの構築・運用に向けたソフトウェアスタック「Infrinia AI Cloud OS」を開発

2026年1月22日 06:30

ソフトバンク株式会社は21日、次世代のAIインフラアーキテクチャーやシステムの開発を担当するInfriniaチームが、AIデータセンター向けのソフトウェアスタック「Infrinia AI Cloud OS」を開発したと発表した。

Infriniaチームは、次世代のAIインフラの推進に向けたソフトバンクの取り組みの一環として、ソフトバンクの完全子会社の米SB Telecom America内に設けられた、インフラアーキテクチャーやシステムの開発を担当するチーム。

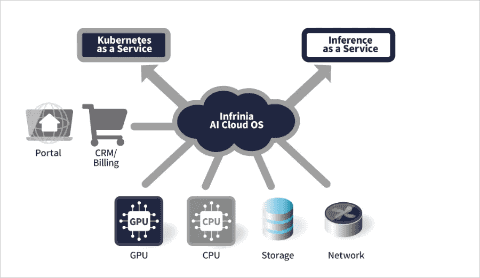

AIデータセンターを運用する事業者は、Infrinia AI Cloud OSを導入することで、マルチテナント環境に対応したKubernetes as a Service(KaaS)と、大規模言語モデル(LLM)の推論機能をAPIとして提供するInference as a Service(Inf-aaS)を、自社のGPUクラウドサービスの機能として構築できる。

Kubernetes as a Serviceの実現により、NVIDIA GB200 NVL72など最先端のGPU基盤上で、BIOS設定からRAID設定、OS構成、GPUドライバー設定、ネットワーク設定、Kubernetesコントローラー、ストレージ設定までを自動化し、物理インフラおよびKubernetesの運用負荷を低減する。

AIワークロードの要件に応じたクラスターの作成・更新・削除時に、ソフトウェア定義によって物理接続(NVIDIA NVLink)とメモリ(Inter-Node Memory Exchange)を動的かつ即座に再構成することが可能。GPUの近接性やNVIDIA NVLinkドメインに基づく自動ノード割り当てにより、高度に分散されたジョブにおける遅延を低減し、GPU間の接続帯域の活用を最大化する。

また、Inference as a Serviceの実現により、Kubernetesや基盤インフラを意識せず、LLMを選択するだけで推論サービスの運用を可能にする。OpenAIと互換性があるAPIで、既存のAIアプリケーションのドロップインが可能。NVIDIA GB200 NVL72などのコアおよびエッジプラットフォーム上で、複数ノード間でのシームレスなスケーリングを実現する。

さらに、暗号化されたクラスター通信と分離によるテナント隔離機能、システムのモニタリングやフェールオーバーといった運用・保守に関わるメンテナンス作業の自動化、AIデータセンター事業者の管理画面や顧客管理システム、請求システムと接続するためのAPIなどを提供する。

これにより、すでに顧客管理システムなどを持つAIデータセンター事業者や、GPUクラウドサービスを展開する企業などは、GPUのリソースを柔軟に活用しながら、AIモデルの学習から推論までを効率的に行える高度な機能を、自社のサービスに加えられるとしている。

ソフトバンクは今後、自社のGPUクラウドサービスにInfrinia AI Cloud OSを導入する予定。また、Infriniaチームは、Infrinia AI Cloud OSのグローバルでの普及に向けて、海外のデータセンターやクラウド環境への展開を進めていく。