ニュース

ソフトバンクとAmpere、CPU活用で小規模AIモデルの運用を効率化する共同検証を開始

2026年2月18日 14:31

ソフトバンク株式会社は17日、米国の半導体設計企業であるAmpere Computing(以下、Ampere)と、次世代のAIインフラを構成する要素の一つとして、CPUを活用したAIモデルの運用の効率化に向けた共同検証を開始したと発表した。

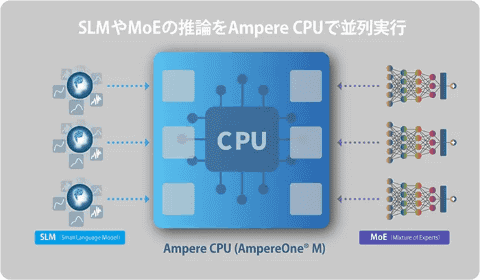

共同検証では、ソフトバンクが開発を進めている、計算資源の管理やAIモデルの最適な配分を行うオーケストレーターと、AIの推論処理向けに設計されたAmpere製のCPUを活用することで、CPUをAI推論用の計算資源として利用できることを確認した。AIエージェントなどで一般的に利用されるSLM(Small Language Model:小規模言語モデル)や、推論の際に一部の専門家(Expert)のみを動作させて計算処理の負荷を抑えるMixture of Experts(MoE)などの推論モデルをCPU上で実行し、AIモデルの運用を最適化することで、計算資源の利用効率向上を実現できるとしている。

AIの普及が加速する中、大規模言語モデル(LLM)だけでなく、特定の用途に特化した、比較的少ないパラメーター数でも高い実用性を発揮するAIモデルの需要が拡大しており、特にAIエージェントや業務の自動化、ネットワーク制御といった分野では、低遅延な応答性と常時稼働を前提とした、高い電力効率を兼ね備えた推論処理が求められているという。こうした背景を踏まえ、ソフトバンクとAmpereは、次世代のAIインフラにおける計算資源の利用効率の向上を目指し、CPUを活用したAI推論環境の運用の効率化および導入に向けた取り組みを開始した。

共同検証では、分散型の計算環境を想定し、AIエージェント向けのSLMおよびMoEモデルを対象に、CPU上でのAI推論環境における性能やスケーラビリティ、運用性を評価した。また、CPUのみを搭載したノードや、CPUとGPUを搭載したノードなどのマルチノード環境を前提として、オーケストレーターに最適な配分制御機能を実装することで、ユースケースや計算処理の負荷などの特性に応じてAIモデルを柔軟に配置・管理し、最適化できることを確認した。

さらに、オープンソースのAI推論フレームワークであるllama.cppをベースに、Ampere製のCPU向けに最適化した「Ampere optimized llama.cpp」を実装することで、一般的なGPUベースの構成と比較して、消費電力を抑えながら同時実行可能数を増加できることを確認した。加えて、AIモデルの読み込み時間が大幅に短縮され、モデルの高速な切り替えもできるとしている。

ソフトバンクとAmpereは今後、これらの成果を生かし、AIエージェント向けに複数のモデルを動的に切り替えながら、TPS(Tokens Per Second:1秒当たりのトークン出力数)を安定的に維持できるAI推論プラットフォームの実現に向けた取り組みを進めていくとしている。ソフトバンクは、Ampereとの協業を通して、次世代のAIインフラを支える要素技術の一つとして、低遅延かつ高効率なAI推論環境の確立を推進し、AIエージェントやSLMのさらなる活用拡大に貢献していくとしている。