ニュース

テラデータ、オンプレミスでAIを利用できるアプライアンス「Teradata AI Factory」を発表

2025年7月31日 11:31

米Teradataは31日、オンプレミスでAIを利用できるアプライアンス「Teradata AI Factory」を発表した。

これに伴い、日本テラデータ株式会社が同ソリューションに関する説明会を7月30日に開催。同社 代表取締役社長の大澤毅氏は、Teradata AI Factoryの開発背景について、「クラウドには置けない機密データを保有する企業は多い。オンプレミスに対応したAIソリューションへの顧客ニーズを受け、オンプレミスで稼働するハードウェア一体型のエージェント型AIソリューションをNVIDIAと共同開発した」と語った。

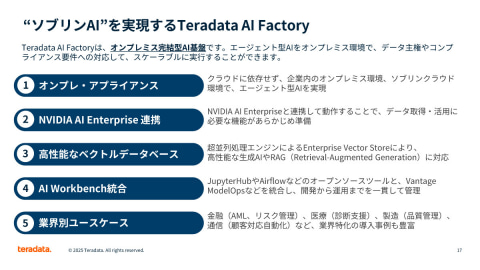

日本テラデータ 技術営業本部 AI技術営業室 室長の八田秦史氏は、Teradata AI Factoryの特徴として、「ソブリンAIを実現していること、高SLAなAIエージェントであること、クラウドの予測しづらいコストを回避できること」を挙げる。

ソブリンAIは、オンプレミス完結型のAI基盤であるからこそ実現できるといい、「クラウドに依存せず企業がデータの主権を取り戻すことができる」と八田氏は語る。オンプレミス環境でのAI実現に向け、「NVIDIA AI Enterprise」と連携し、データ取得や活用に必要な機能をあらかじめ準備した。

Teradata AI Factoryは、大規模言語モデル(LLM)と業務特化型の小規模言語モデル(SLM)を併用することで、高SLAと高コスト効率を実現している。「LLMは数百億から数兆にもおよぶパラメーター数で汎用的な利用ができる反面、コストが非常に高くなることやレスポンスタイムが遅くなる場合があるほか、ハルシネーションも起こりやすい。一方、小規模言語モデルは汎用的ではないが、業務に特化することでコスト効率やSLAが高く、ハルシネーションも抑えられる」と、八田氏はその特徴を説明した。

「今後エージェント型AIを実現する場合、マルチエージェントに対応し、それらをオーケストレーションする必要がある。その際にはLLMとSLMを組み合わせ、最適なSLAやコスト効率を検討することが重要だ。Teradata AI Factoryはこれらを組み合わせて実現できるため、エージェント型AIでも利用できる」(八田氏)。

Teradata AI Factoryは、ローカルアーキテクチャによってデータ移動の削減や遅延の低減ができ、AIモデルをCPU上で実行することやGPUで加速させることが可能だ。また、Teradata AIマイクロサービスとNVIDIA NeMoを組み合わせることで、埋め込みや検索、ガードレールを統合したRAGパイプライン機能を提供し、すべてのデータに対して自然言語でのクエリが可能になる。これにより、大規模なデータからより迅速に高度なインサイトを導き出せるという。

また、Teradata AI Factoryは、AIに最適化されたIntelliFlexプラットフォームを基盤に構築されており、AIアプリケーションに混在する構造化データと非構造化データを統合するTeradata Enterprise Vector Storeを組み込んでいる。

さらには、カスタマイズしたエージェント型AIを開発できるよう、新たにAI Workbenchを用意。ClearScape Analyticsなどのライブラリや関数にアクセス可能なセルフサービス型ワークスペースを提供する。モデルのライフサイクル管理やコンプライアンス、ワンクリックLLMデプロイメントの組み込みサポートに加え、JupyterHub、ModelOps、Airflow、Gitea、Devpiなどのツールでデプロイメントを効率化するという。

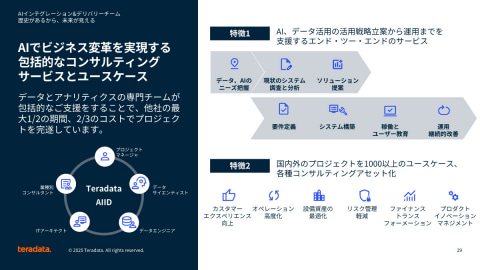

こうしたAIソリューションを迅速に展開できるよう、日本テラデータでは今月、AIに特化したコンサルティングサービス部門となる「AIインテグレーション&デリバリーチーム」(Teradata AIID)を新設した。

日本テラデータ 執行役員 コンサルティング本部 本部長の小峰誠司氏は、Teradata AIIDについて、「プロジェクトマネージャー、データサイエンティスト、データエンジニア、ITアーキテクト、業種別コンサルタントといった専門集団がワンチームとなって、AIやデータ活用の戦略立案から運用までを包括的に支援する」と説明する。

「テラデータでは、国内外で1000以上のプロジェクトを手掛けた実績があり、各種コンサルティングのノウハウをユースケースとして体系化している。顧客の課題はこのユースケースのいずれかに当てはまるため、ゼロからのスタートではないところが大きなポイントだ」と、小峰氏はその強みを語った。