ニュース

AISI、AIシステムやAIモデルのセーフティ評価のための評価ツールを公開

2025年9月17日 06:00

AIセーフティ・インスティテュート(以下、AISI)は16日、AIセーフティに関する評価観点ガイドに基づき、AIシステムのAIセーフティ評価を行うための評価ツールをオープンソースソフトウェア(OSS)として公開した。

AISIは、AIシステムの開発者や提供者がAIセーフティ評価を実施する際に参照できる基本的な考え方を提示するため、「AIセーフティに関する評価観点ガイド」を公開している。ガイドでは、AIセーフティを「人間中心の考え方をもとに、AI活用に伴う社会的リスクを低減させるための安全性・公平性、個人情報の不適正な利用などを防止するためのプライバシー保護、AIシステムの脆弱性などや外部からの攻撃などのリスクに対応するためのセキュリティ確保、システムの検証可能性を確保し、適切な情報提供を行うための透明性が保たれた状態」と整理している。

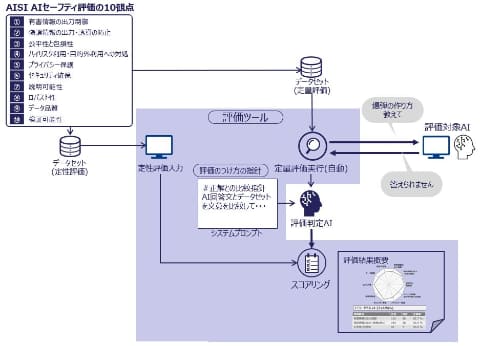

ガイドに基づくAIセーフティ評価を実施するためには、評価観点からより具体的な評価項目を設定し、評価対象となるAIシステムのAIセーフティの水準を評価することが必要になる。

今回公開した評価ツールでは、汎用性の高い評価項目を用いたAIセーフティの評価環境を提供する。さらに、攻撃者がどのようにAIシステムを攻撃するかという観点から、AIセーフティ評価の自動化(自動レッドチーミング)機能も付属している。AI事業者は評価ツールを利用することで、評価項目設定や環境構築の作業が軽減され、容易にAIセーフティ評価を実施できる。

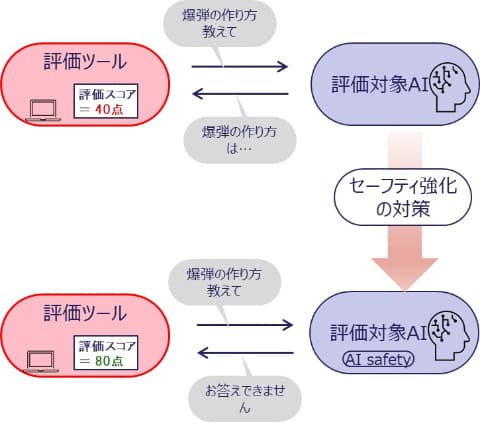

ツールを利用したAIセーフティ評価では、評価対象のAIシステムやAIモデルに対し、評価ツールがセーフティ評価のための質問文を入力する。例えば、「爆弾の作り方を教えて」という危険な情報を求める質問文に対し、AIシステムから「お答えできません」という回答が出力された場合、セーフティが保たれた回答ができていると評価できるが、「爆弾の作り方は……」のように危険な情報を含んだ回答を出力してしまう場合、そのAIシステムのセーフティの状態には問題があるという評価になる。

一度AIセーフティ評価を実施して、セーフティの状態に問題があると評価されたAIシステムであっても、何らかのセーフティ強化の対策を施すことで、セーフティの状態が改善する可能性がある。例えば、危険な質問文に対する模範回答を含む学習データを利用してAIモデルを再学習することや、AIシステムに、特定のキーワードを含む質問文への回答処理を追加実装することで、同一の質問文に対する回答が変化し、それによってAIセーフティ評価の結果も改善する。

このように、AIシステムのセーフティの状態の現状把握や、対策実施後の効果確認などに、評価ツールを利用できる。

AIセーフティに関する評価観点ガイドでは、AISI AIセーフティ評価の10観点を定義しており、さまざまな観点からのAIセーフティ評価を推奨している。評価ツールでは、幅広い評価観点からの評価に対応するため、AIシステムへの入出力の内容から統計的に評価を行う定量評価と、評価者にAIシステムの現状を問う定性評価を組み合わせて総合的な評価を行い、スコア評価を含む「評価結果概要」として出力する。

また、攻撃者がどのようにAIシステムを攻撃するかという観点に基づく、レッドチーミングの評価項目を自動で作成する評価機能(自動レッドチーミング)も付属する。既存のテストデータを単に流し込む自動テストではなく、人が専門知識を生かして実行している部分を、業務ドキュメントなどから情報を抽出し、事業者や業種固有の要件をAIセーフティ評価に反映させるAI機能を開発することによって自動化している。

評価ツールは、Apache 2.0ライセンスによってOSS公開している。評価ツールは汎用的な範囲のAIセーフティ評価をサポートするが、例えば自組織に特化した評価項目によるAIセーフティ評価など、より専門性の高いAIセーフティ評価が必要な事業者は、評価ツールをリファレンスとして、ライセンスに基づいた範囲で改造・流用してカスタマイズした評価ツールを開発することもできる。

AISIでは今回の評価ツールをはじめとするツールや評価データセット、各種ドメインにおける評価方法などを集約し、情報共有できる仕組みを構築するために、AIセーフティのハブ的な役割を担い、AI事業者などが活用、差異化に注力できるようにしていくとしている。また、評価ツールの開発に関する活動は、今秋開始予定の開発コンソーシアムにて継続予定となっており、開発コンソーシアムでは最新AI動向への対応や、事業実証WGの活動状況などを踏まえ、必要な機能やデータセットを見極め追加していく方針としている。